Yapay zeka odaklı çip üretimiyle dikkatleri üzerine çeken Nvidia dün gerçekleşen yapay zeka odaklı GTC konferansında yeni yazılım platformu Nvidia NIM'i duyurdu. Nvidia NIM, özel ve önceden eğitilmiş yapay zeka modellerinin üretim ortamlarına dağıtımını kolaylaştırmak için tasarlandı.

NIM, NVIDIA AI Enterprise'ın bir parçası olarak konumlanıyor. NIM, bulut, veri merkezi ve GPU hızlandırmalı iş istasyonları dahil olmak üzere hemen her yerde üretimsel yapay zeka modellerinin dağıtımını basitleştirmeye odaklanıyor. Böylece üretimsel yapay zeka modellerilerinin pazara sunulma süresinin kısaltılması amaçlanıyor.

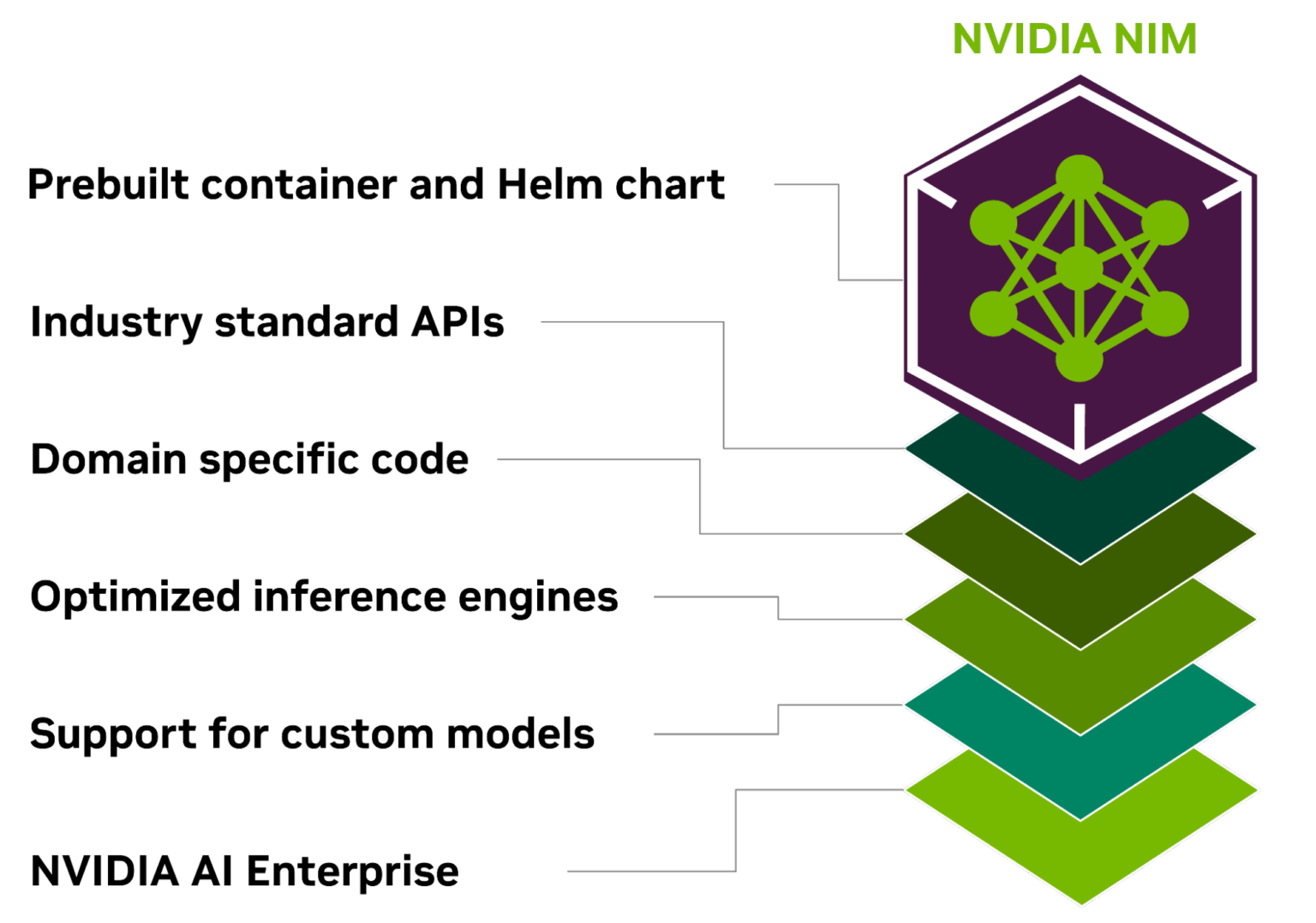

Nvidia NIM'i optimize edilmiş bulut tabanlı mikroservislerden oluşan bir set olarak tanımlamak mümkün. NIM, endüstri standardı API'leri kullanarak üretim için yapay zeka modeli geliştirme ve paketlemenin karmaşıklıklarından uzaklaşıyor. NIM'in kullanıcıları arasında Box, Cloudera, Cohesity, Datastax, Dropbox ve NetApp bulunuyor.

NIM'in desteklediği modeller

NIM şu anda NVIDIA, A121, Adept, Cohere, Getty Images ve Shutterstock modellerini destekliyor. Bu modellerin yanı sıra Google, Hugging Face, Meta, Microsoft, Mistral AI ve Stability AI'ın açık modellerinin de desteklendiğini belirtelim.

Nvidia, bahsi geçen NIM mikro hizmetlerini sırasıyla SageMaker, Kubernetes Engine ve Azure AI üzerinde kullanılabilir hale getirmek için Amazon, Google ve Microsoft ile birlikte çalışıyor. Buna ek olarak Deepset, LangChain ve LlamaIndex gibi framework'lere entegrasyon sunulacağını da eklemekte fayda var.

NIM nasıl çalışıyor?

NIM, Nvidia'nın çıkarım yapma ve modelleri optimize etme konusunda yaptığı yazılım çalışmalarını daha erişebilir hale getiriyor. NIM, bunu yapmak için belirli bir modeli optimize edilmiş bir çıkarım motoruyla birleştiriyor ve ardından bunu bir container'ın içine paketliyor. Böylece çalışmalar, bir mikroservis olarak daha erişilebilir hale geliyor.

Bu arada çıkarım motoru, Nvidia Triton Inference Server, TensorRT ve TensorRT-LLM'i kullanıyor. NIM aracılığıyla kullanılabilecek Nvidia mikroservisleri arasında Riva, cuOpt ve Earth-2 modeli yer alacak. Riva, konuşma ve çeviri modellerini özelleştirmek için kullanılırken, cuOpt yönlendirme optimizasyonları için tercih ediliyor. Earth-2 modeli ise hava durumu ve iklim simülasyonları için kullanılmakta.

İlerleyen dönemde şirket, Nvidia RAG LLM operatörünü bir NIM olarak kullanılabilir hale getirmeyi planlıyor. Şirketin platforma eklemeyi planladığı özellikler arasında yapay zeka sohbet robotları oluşturmayı kolaylaştırmak da yer alıyor.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap