Nvidia, demo uygulaması Chat with RTX'in erken sürümünü yayınladı. Uygulama bilgisayarınızda kişisel bir yapay zeka sohbet botu çalıştırmanıza imkan tanıyor. Chat with RTX'i kendi belgelerinizin yanı sıra YouTube videolarıyla da besleyebiliyorsunuz. Böylece özetler çıkarabilirken, kendi verilerinize dayalı alakalı yanıtlar da alabiliyorsunuz.

Tüm süreç kişisel bir bilgisayarda (PC) yerel olarak çalışıyor. Bu noktada yalnızca en az 8 GB VRAM'e sahip bir GeForce RTX 30 veya RTX 40 serisi GPU'ya ihtiyacınız var.

Chat with RTX'in öne çıkan özellikleri

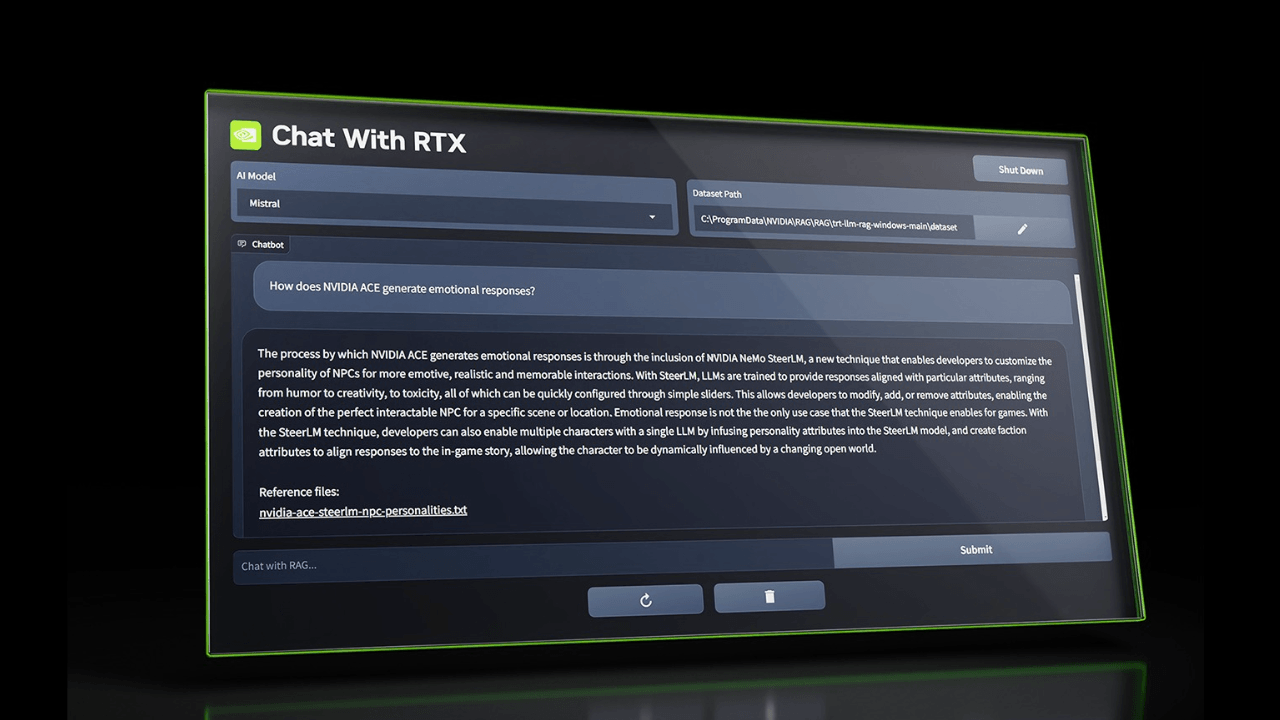

Chat with RTX varsayılan ayarlar kapsamında yapay zeka girişimi Mistral'in açık kaynak modelini kullanıyor. Ayrıca araç, Meta'nın Llama 2'si de dahil olmak üzere diğer metin tabanlı modelleri de desteklemekte. Nvidia'nın paylaştığı bilgilere göre; gerekli tüm dosyaların indirilmesi, seçilen modellere bağlı olarak 50GB ila 100GB gibi bir depolama alanı kaplıyor.

Chat with RTX metin, PDF, .doc, .docx ve .xml formatlarıyla çalışıyor. Uygulama, desteklenen dosyaları içeren bir klasöre yönlendirildiğinde, dosyalar modelin ince ayar veri kümesine yükleniyor. Ayrıca Chat with RTX , bir YouTube oynatma listesinin bağlantısını alarak oynatma listesindeki videoların transkripsiyonlarını da yükleyebiliyor. Bununla beraber, söz konusu videoların içeriklerini seçtiğiniz her modelde sorgulayabiliyor.

Tüm bu özelliklere rağmen aracın çeşitli sınırlamaları da mevcut. Chat with RTX, bağlamı hatırlayamıyor. Bu anlamda uygulama, devam sorularını yanıtlarken önceki soruları dikkate almıyor.

Ayrıca uygulamanın yanıtlarının alakası, soru cümlesi, seçilen modelin performansı ve ince ayar veri kümesinin boyutu gibi faktörlerden etkilenebiliyor. Nvidia'nın paylaştığı bilgilere göre; yanıt kalitesi genellikle daha büyük veri kümeleriyle artabilir. Böylece Chat with RTX, kullanıcıları belirli bir konu hakkında daha fazla içeriğe yönlendirebilir.

Böyle bakıldığında şu an için Chat with RTX'in piyasadaki devlerle rekabet etmekten uzak olduğunu söyleyebiliriz. Yine de aracın yerel olarak bilgisayarda çalışabilmesi önemli bir değer önerisi sunuyor. Zira çevrimdışı modellerin işledikleri veriler, çalıştıkları cihazdan ayrılmıyor. Aynı zamanda bulutta barındırılan modellere göre daha uygun maliyetli olan bu modeller, daha düşük gecikme süresiyle de öne çıkıyor. Chat with RTX'in önümüzdeki dönemde nasıl konumlanacağını hep birlikte izleyip göreceğiz.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap