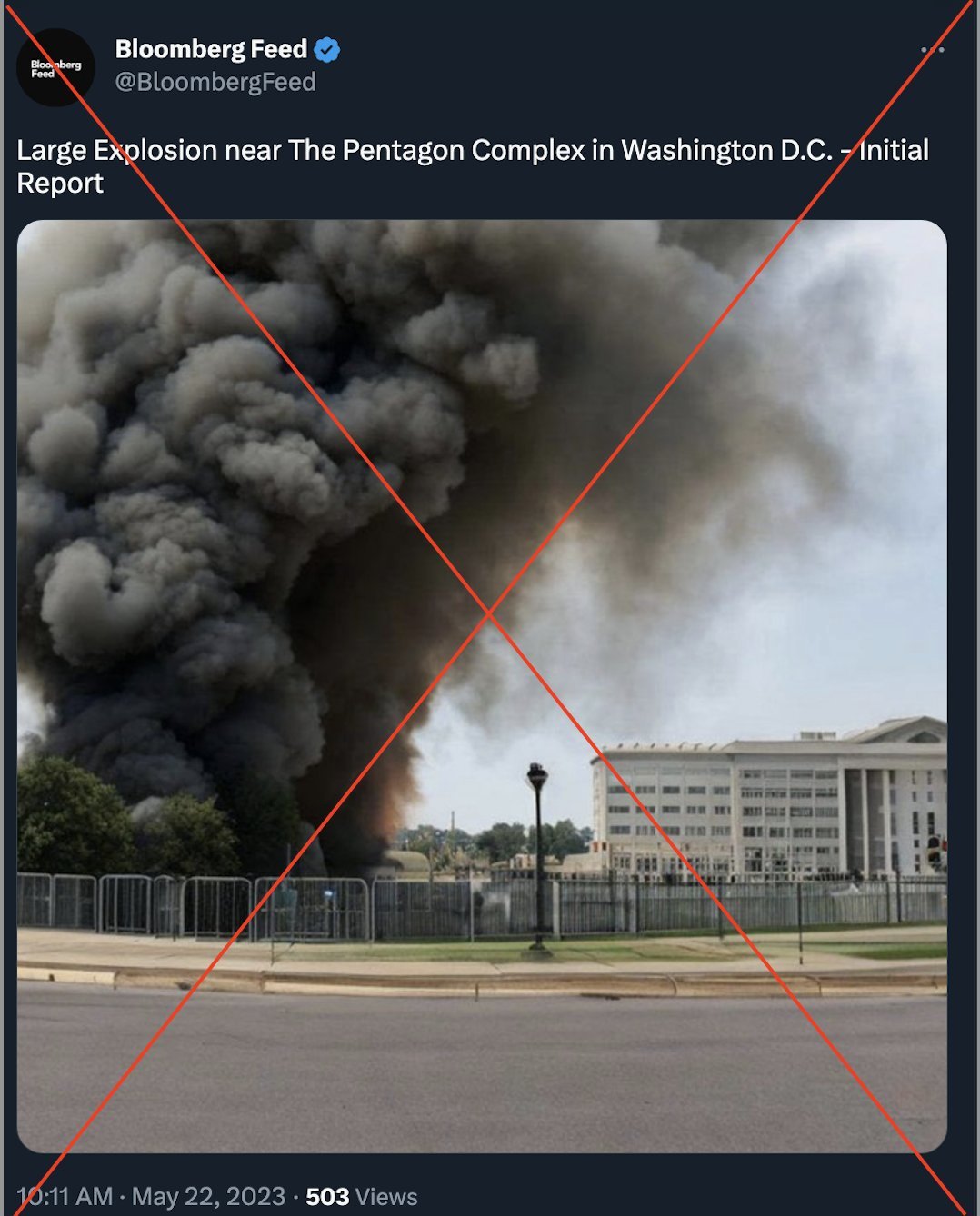

Yapay zeka söz konusu olduğunda, bu teknoloji ile son dönemde neler yapılabileceğinden ziyade neler yapılamayacağını konuşmaya başladık. Çünkü yapay zeka, kısa sürede öyle bir noktaya geldi ki artık kendimizi, bilim kurgu filmlerinde gördüğümüz dünyayı ele geçiren robotların varlığına bile çok yaklaşmış hissediyoruz. Ancak bana kalırsa yapay zekanın insanlığı zorladığı ilk nokta, ne katil robotlar ne de insanın yerini alan teknolojiler olacak. Hepimizin gözden kaçırdığı, bu teknoloji böyle popüler olmadan önce bile bir şekilde hayatlarımızda var olan başka bir problem var; dezenformasyon. Zaten bunun da örneğini çok kısa bir süre önce Pentagon patlaması fotoğrafı ile gördük.

Öncelikle neler olduğundan bahsedelim. Pazartesi günü, Pentagon binasının yanında gerçekleşen patlamayı gösteren bir fotoğraf, Twitter'da bir anda popüler oldu. Tabii ki sosyal medya platformunda bir anda panik ortamı oluştu ve herkes işin aslını öğrenmeye çalıştı. Olayın hemen ardından Arlington Polis Departmanı, "Pentagon bölgesinde veya yakınında hiçbir patlama veya olay meydana gelmiyor ve halk için acil bir tehlike yok" tweet'iyle görüntünün gerçek olmadığını açıkladı. Hatta bu olaydan sonra borsada düşüş bile yaşandı.

Peki, bu fotoğraf neden gerçek zannedildi? Fotoğrafın gerçek olmadığını anlamak için hangi yollar izlenebilirdi?

Nick Waters adlı Twitter kullanıcısı aslında bu konuya oldukça güzel bir açıklama getirmiş ve Waters'ın açıklamalarından yola çıkılarak, biraz dikkat ile bu fotoğrafın yapay zeka tarafından oluşturulduğu kolaylıkla anlaşılabiliyor. Fotoğrafa baktığımızda bazı kısımlarda bozulmalar olduğunu görüyoruz, mesela kimi yerde binanın ön cephesi ile çitler birbirine karışmış durumda. Ancak en önemlisi bu fotoğraf dışında hiçbir patlama fotoğrafının paylaşılmamış olması.

https://twitter.com/N_Waters89/status/1660651721075351556?s=20

Bir içeriğin sahte olduğunu anlamak için yapılabilecekler

Düşünsenize, bir olay olduğunda o olayın farklı açılardan birçok videosunu ve fotoğrafını kısa süre içinde görmeye başlıyoruz. Buradaki en önemli nokta söz konusu içeriklerin gerçek ve farklı hesaplar tarafından paylaşılıyor olması. Yani herhangi bir olayı, Twitter'da arattığınızda hem popüler hem son gönderiler, hem de video ve fotoğraflar kısmından bulmaya çalışıyorsunuz. Diyelim ki benzer fotoğrafları başkaları da paylaştı ve biz de olayın gerçek olduğunu düşünmeye başladık; burada da paylaşan kişilerin Twitter hesaplarını biraz irdelemek gerekiyor. Önceden neler paylaşmış, gerçek bir kişi mi gibi soruların cevapları da bu noktada bize yardımcı olacaktır. Zaten kişi hiçbir şeyden emin değilse böyle fotoğrafları mümkün olduğunca yaymaması gerekiyor, aksi düşüncesiz bir yardımseverliğe dönüşüyor.

Bu örnekten yola çıkarak son dönemde bu şekilde çok fazla dezenformasyon yapılabileceğini görüyoruz ki bu da oldukça korkutucu bir şey. Özellikle deepfake teknolojisi ile birçok kişinin söylemedikleri söylenmiş gibi gösteriliyor, kimi zaman kişilerin aslında olmayan cinsel içerikli videoları paylaşılıyor ve internetin bizi izlediği bu çağda bunların kişinin peşini bırakmayacağı düşünülmüyor bile. Çünkü bizler, hemen hemen her şeye hiç düşünmeden, tartmadan dahil olmayı çok seviyoruz. Bence bu noktada korkutucu olan teknolojinin kendisi değil, insanların asla sorgulamadan bu teknoloji ile oluşturulan sahte videoları gerçekmiş gibi algılaması ve başkalarının da kendileri gibi düşünmesini istemesi.

Yapay zeka teknolojisinin yol açabileceği olumsuzluklar

Yapay zekanın insanlara yapabileceği tek kötülük bu da değil. Örneğin; yapay zeka algoritmaları yanlış veri örüntülerine dayalı kararlar verebilir, önyargıları yansıtabilir veya hatalı sonuçlar üretebilir. Bunları sıklıkla görüyoruz. Geçtiğimiz günlerde akademisyen bir arkadaşım, ödev olarak verdiği bir kitaba dair içerik istediği zaman, öğrencilerin yapay zeka ile bu içeriği oluşturduğunu ve aslında oluşturulan içeriğin kitapla ilgisinin bile olmadığını söyledi. Yani yapay zeka aslında hiç olmayan bir kitabı anlatmıştı. Bunun gibi aslında çok fazla örneğe rastlıyoruz. Ünlülerin biyografileri, şirketler hakkında kısa bilgiler bile kimi zaman yanlış olarak aktarılıyor. Gerçekten ikinci bir araştırma yapılmasa bu bilgilerin doğru olduğu bile düşünülebilir.

Bu tür hatalar, yapay zeka sistemlerinin doğru bir şekilde tasarlanmaması, eğitilmemesi veya test edilmemesinden kaynaklanabiliyor. Yani söz konusu teknolojiler eğitildikçe aslında yanlış yapma oranı da azalıyor. Örneğin; OpenAI'ın GPT-4'ü diğer sürümlerine göre şu anda bu alanda çok daha başarılı. Ama yine de bir noktada patlayabilir mi, açıkçası bilemiyorum.

Yapay zeka teknolojilerinin olumsuz etkileri arasında, sahte haberler, sahte görüntüler, manipüle edilmiş içeriklerin üretilmesi ve yayılması, kişisel gizlilik ihlalleri, siber saldırılar, otomatik silahlar, stok fiyat manipülasyonu, işsizlik ve iş yeri değişiklikleri gibi birçok yer alabilir. Bu teknolojinin olumsuz etkilerini azaltmak için, doğru bir şekilde tasarlanması, eğitilmesi, test edilmesi ve düzenlenmesi gerekiyor. Dün, OpenAI'ın yöneticilerinin bile bu konuda önerileri olduğunu söylemiştik. Yani ChatGPT'yi hayatımıza sokan şirket bile bu alanda düzenlemelerin yapılması gerektiğini; aksi halde çok tehlikeli sonuçlar doğabileceğini söylüyor.

Pentagon fotoğrafı bunun küçük bir örneği. Kolay çözülebilen, çabuk anlaşılabilen bir sahte fotoğraf. Ancak sahte fotoğraf, video vb. bir şey bir gün aynısı bizlerin başına gelirse bunu kanıtlayacak kimse olmayabilir. Bu yüzden yapay zeka teknolojisinin getirilerine olduğu kadar götürülerine de dikkat etmek yapılabilecek en iyi şey olacaktır.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap