"Fırının üzerinde iki pizza var"

"Bir grup insan pazarda alışveriş yapıyor"

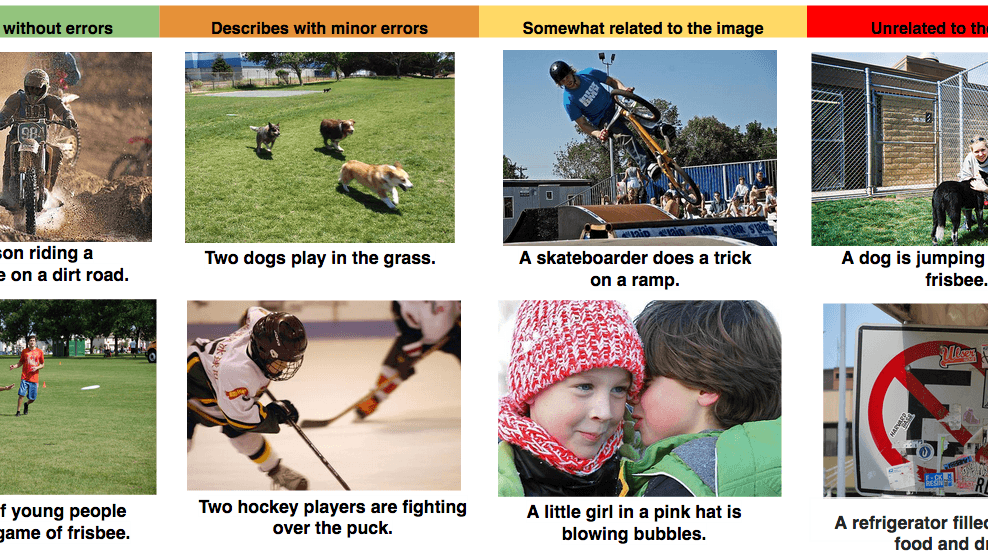

Bir resime bakmak ve onu tarif etmek insanlar için çocuk oyuncağı olsa da, makineler için henüz oldukça karmaşık bir görev. Ancak Google ve Stanford'dan araştırmacılar, bağımsız sürdürdükleri çalışmalarıyla, bu hedefe biraz daha yaklaştıklarını duyurdular.

Araştırmacıların geliştirdikleri machine learning sistemi, ilk kez karşılaştıkları bir görselin içeriğini, yukarıda örneklerini gördüğünüz cümlelere benzer tarifler kullanarak tasvir edebiliyor. Araştırmacıların sağladığı ilerlemenin, bugün yalnızca isimleriyle arayabildiğimiz görselleri, ileride içerikleriyle arayabilmemizi mümkün hale getirebileceği belirtiliyor. Buna ek olarak, görme engelli insanların baktıkları resimleri anlaması ve mobil bağlantı hızının yavaş olduğu bölgelerde, resimler yerine metin alternatifi sunulabilmesi gibi farklı kullanım alanları olabileceği notlar arasında.

Araştırmacıların geliştirdikleri machine learning sistemi, ilk kez karşılaştıkları bir görselin içeriğini, yukarıda örneklerini gördüğünüz cümlelere benzer tarifler kullanarak tasvir edebiliyor. Araştırmacıların sağladığı ilerlemenin, bugün yalnızca isimleriyle arayabildiğimiz görselleri, ileride içerikleriyle arayabilmemizi mümkün hale getirebileceği belirtiliyor. Buna ek olarak, görme engelli insanların baktıkları resimleri anlaması ve mobil bağlantı hızının yavaş olduğu bölgelerde, resimler yerine metin alternatifi sunulabilmesi gibi farklı kullanım alanları olabileceği notlar arasında.

Görüntü tanıma yazılımları, her gün eklenen milyonlarca görsel sayesinde, hızla gelişmeye devam ediyor. Görüntüyü tanıma, eşleme ve adlandırma konusunda ciddi ilerlemeler sağlansa da, araştırmacılar, karmaşık bir sahnede ne olduğunu tarif etmenin, görseldeki farklı nesnelerin birbiriyle nasıl ilişkilendiğini seçmeyi ve bunları kulağa doğal gelen bir dile tercüme edebilmeyi gerektirdiğini söylüyorlar.

Araştırmacılar bu görev için, bugüne kadar ayrı ayrı kullanılan bilgisayar görüntü ve doğal dil işleme modellerini birlikte eğiterek tek bir sistem haline getirmiş. Bir görseli ele alıp, bundan doğrudan insanların okuyabileceği sırada kelimeler üretmeye odaklamışlar. Benzer yaklaşımlar takip eden her iki grup araştırmacı da bunun için nöral ağları taklit eden iki tip yazılımla (Recurrent Neural Network ve Convolutional Neural Network) çalışmış, bunlardan biri görselleri tanımaya diğeri de insan diline odaklanmış.

Bu şekilde yazılıma görseldeki kalıpları tanımayı ve bunları tasvir cümleleriyle anlatmayı öğreten araştırmacılar, ardından makinelerin daha önce görmedikleri görsellerle teste devam etmişler. Araştırma, henüz küçük bir veri setiyle yapılmış olmasına rağmen, eğitilen programların nesne ve eylemleri tanıyabildiklerini görmüşler. Makinelerin bu konudaki becerisini henüz insanlarınkinden uzak da olsa, araştırmacılar, bugüne kadar yapılan çalışmalardan iki kat daha başarılı sonuçlar elde etmişler.

Bu şekilde yazılıma görseldeki kalıpları tanımayı ve bunları tasvir cümleleriyle anlatmayı öğreten araştırmacılar, ardından makinelerin daha önce görmedikleri görsellerle teste devam etmişler. Araştırma, henüz küçük bir veri setiyle yapılmış olmasına rağmen, eğitilen programların nesne ve eylemleri tanıyabildiklerini görmüşler. Makinelerin bu konudaki becerisini henüz insanlarınkinden uzak da olsa, araştırmacılar, bugüne kadar yapılan çalışmalardan iki kat daha başarılı sonuçlar elde etmişler.

Google ve Stanford araştırmacıları, çalıştıkları veritabanlarını ve yazılımları geliştirerek aldıkları sonuçlarda büyük ilerleme sağlayabileceklerini söylüyorlar. İncelemek isterseniz Stanford University tarafından yayımlanan araştırma burada; Google tarafından yayımlanan ise burada.