Geçtiğimiz haftalarda Qwen App'e agentic yetenekler eklemesiyle gündeme gelen Alibaba Group, gelişmiş özelliklere sahip en yeni yapay zeka modeli serisi Qwen3.5'i piyasaya sürdü. Qwen3.5 yapay zeka modeli, kullanıcıların kendi altyapılarında modeli çalıştırmalarına, ince ayar yapmalarına ve dağıtmalarına imkan tanıyan açık ağırlıklı Qwen3.5-397B-A17B adlı bir versiyona sahip. Alibaba ayrıca, Qwen-3.5-Plus adlı barındırılan bir versiyon da piyasaya sürdü. Bu versiyonda model, Alibaba'nın kendi sunucularında çalışabiliyor. Qwen-3.5-Plus'a Poe üzerinden erişmek de mümkün.

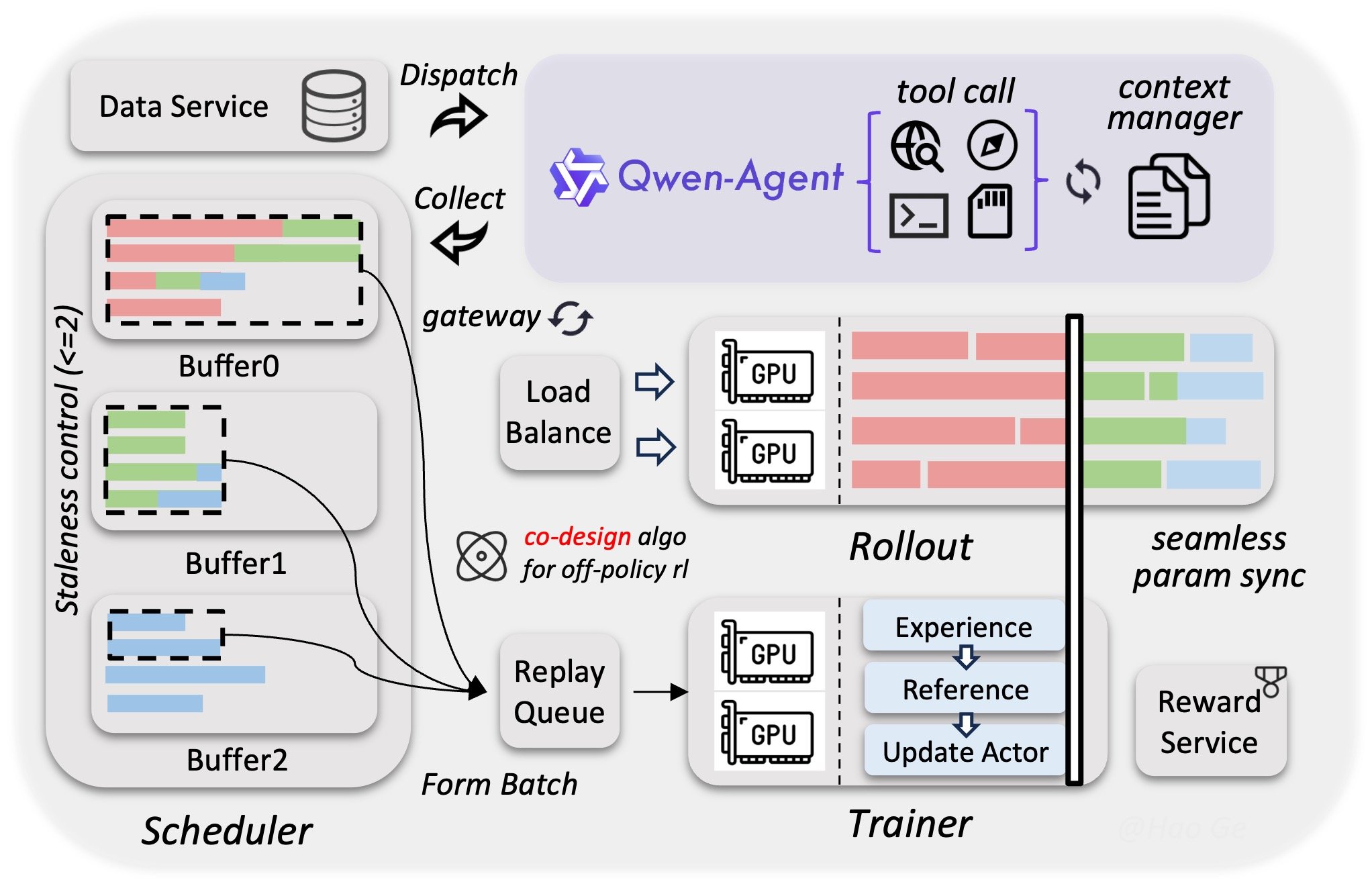

Alibaba'nın belirttiğine göre; performans ve maliyet açısından iyileştirmeler sunan Qwen3.5, tek bir sistem içinde metin, görüntü ve videoyu aynı anda anlayabilmesini sağlayan yerel multimodal yetenekler ile geliştirildi. Model, yeni kodlama ve ajan yeteneklerini de desteklerken, son dönemde dikkatleri üzerine çeken OpenClaw gibi açık kaynaklı yapay zeka ajanlarıyla uyumlu.

Qwen3.5, varsayılan olarak 262 bin 144 token'a kadar komut işleyebiliyor. Ayrıca geliştiriciler, özelleştirmeler uygulayarak bu sayıyı yaklaşık dört katına çıkarabiliyor. Söz konusu komutlar, 210'dan fazla dil ve lehçede metinlerin yanı sıra veri görselleştirmeleri gibi görüntüleri de içerebiliyor.

Uzmanlar karşımı (mixture of experts) mimarisine sahip olan Qwen3.5, farklı görevler için optimize edilmiş birden fazla sinir ağından oluşuyor. Bu bağlamda büyük dil modeli, bir komut aldığında, 10 sinir ağını kullanarak bir cevap üretiyor. Böylece komutları işlemek için modelin yalnızca bazı bileşenlerini etkinleştirmek mümkün oluyor. Bu yaklaşım, tüm yapay nöronları kullanmak yerine donanım açısından daha verimli bir yol sunuyor. Toplam 397 milyar parametreye sahip olan Qwen3.5, komut başına bunların 17 milyarını kullanıyor.

Bu arada Qwen3.5, standart kuadratik dikkat başlıklarını (quadratic attention heads), çok daha az bellek gerektiren lineer dikkat başlıklarıyla birleştiriyor. Büyük bir dil modelinin karar verirken hangi veri noktalarını dikkate alacağını belirlemek için kullandığı mekanizmalar olan dikkat başlıklarının genellikle kuadratik olarak ölçeklendiğini belirtmekte fayfda var. Bu kapsamda bir komut satırındaki veri miktarı iki katına çıktığında yanıt üretmek için gereken RAM miktarı da dört katına çıkmaktaydı. Qwen3.5, bu alanda daha verimli bir yaklaşımla karşımıza çıkıyor.

Model ayrıca, başka bir verimlilik artırıcı teknoloji olan gated delta network'ü de kullanıyor. Bu teknoloji, gating ve delta kuralı olarak bilinen iki derin öğrenme tekniğini birleştiriyor. Gating, bir LLM'nin bir görev için ihtiyaç duymadığı verileri belleğinden kaldırmasını sağlarken, delta kuralı ise LLM'lerin eğitim sırasında yeni görevleri öğrenmek için kullandıkları geri yayılım (back-propagation) algoritmasının bir versiyonu olarak karşımıza çıkıyor.

Qwen3.5'in GPT-5.2 ve Claude 4.5 Opus'tan bazı görevlerde daha iyi performans gösterdiği belirtiliyor. Qwen3.5, LLM'lerin kullanıcı talimatlarını ne kadar iyi takip ettiğini ölçen IFBench ölçütünde GPT-5.2 ve Claude 4.5 Opus'u geride bıraktı. HMMT muhakeme karşılaştırmasında Claude 4.5 Opus'un elde ettiği puanı aştı, ancak GPT-5.2'nin gerisinde kaldı. Qwen3.5'e açık kaynak lisansı altında Hugging Face'ten erişmek mümkün.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap