Çin merkezli e-ticaret devi Alibaba'nın yapay zeka araştırmacılarından oluşan Qwen ekibi, bu hafta, vibe coding'e odaklanan Qwen3-Coder-Next ile karşımıza çıktı. 80 milyar parametreli özel bir model olan Qwen3-Coder-Next, ileri geçiş başına yalnızca 3 milyar parametreyi etkinleştiren ultra seyrek Mixture-of-Experts (MoE) mimarisini kullanıyor. Bu tasarım sayesinde model, hafif bir yerel modelin düşük dağıtım maliyetlerini ve yüksek verimini koruyor. Aynı şekilde devasa özel sistemlerle rekabet edebilecek akıl yürütme yetenekleri sunuyor.

Qwen3-Coder-Next'in mimarisi ve eğitim süreci

Qwen3-Coder-Next'in geleneksel Transformer'ları etkileyen ikinci dereceden ölçeklendirme sorunlarını aşmak için özel olarak tasarlanmış bir hibrit mimarden yararlandığını söyleyebiliriz. Böylece model, uzun vadeli akıl yürütmede tipik olan aşırı gecikme cezaları olmadan çeyrek milyon token'lık penceresinde durumunu koruyabiliyor. Bu yaklaşım ultra seyrek MoE ile eşleştirildiğinde, Qwen3-Coder-Next benzer toplam kapasiteye sahip yoğun modellere kıyasla depo düzeyindeki görevler için teorik olarak 10 kat daha yüksek verim sunuyor.

Söz konusu mimarinin, bir ajanın tüm Python kütüphanesini veya karmaşık JavaScript framework'ünü okuyabilmesini ve 3B modelin hızıyla yanıt verebilmesini sağladığını söyleyebiliriz. Üstelik modelin, 80B sistemin yapısal anlayışına sahip olması da dikkat çekici. Ekip, ayrıca Best-Fit Packing (BFP) yöntemini kullandığını belirtiyor. Best-Fit Packing (BFP)'i geleneksel belge birleştirmede bulunan kesme hataları olmadan verimliliği koruyan bir strateji olarak tanımlayabiliriz. Best-Fit Packing'in kullanılmasıyla eğitim sırasında ortaya çıkan bağlam halüsinasyonunun önüne geçiliyor. Ayrıca şimdiye kadar kodlama modellerinin statik kod-metin çiftleri üzerinde eğitildiğini gördük. Qwen3-Coder-Next ise devasa bir “ajan eğitimi”süreciyle geliştirildi.

Modelin öne çıkan özellikleri

Modelin öne çıkan özellikleri arasında 370 programlama dili desteği, XML stili araç çağırma ve depo düzeyi odaklanma yer alıyor. Önceki sürümlerdeki 92 dil desteğine kıyasla Qwen3-Coder-Next 370 programlama dili destekleyerek, hareket alanını genişletiyor. XML Stili Araç Çağırma kapsamında dizgi ağırlıklı argümanlar için tasarlanmış yeni bir qwen3_coder formatı, modelin JSON'da tipik olan iç içe alıntı ve kaçış yükü olmadan uzun kod parçacıkları üretmesini sağlıyor. Depo Düzeyi Odaklanma özelliğinde ise orta düzey eğitim, depo düzeyinde verilerin yaklaşık 600 milyar token'ına genişletiliyor. Qwen3-Coder-Next'ten bir deponun 262 bin token'Inı saniyeler içinde işleyebilen ve kendi çalışmasını bir Docker konteynerinde doğrulayabilen bir model olarak bahsedebiliriz. Bu anlamda geliştiriciler, yinelemesi çok yavaş veya pahalı olan daha büyük bir model yerine Qwen3-Coder-Next'i tercih edebilir.

Modelin performansı

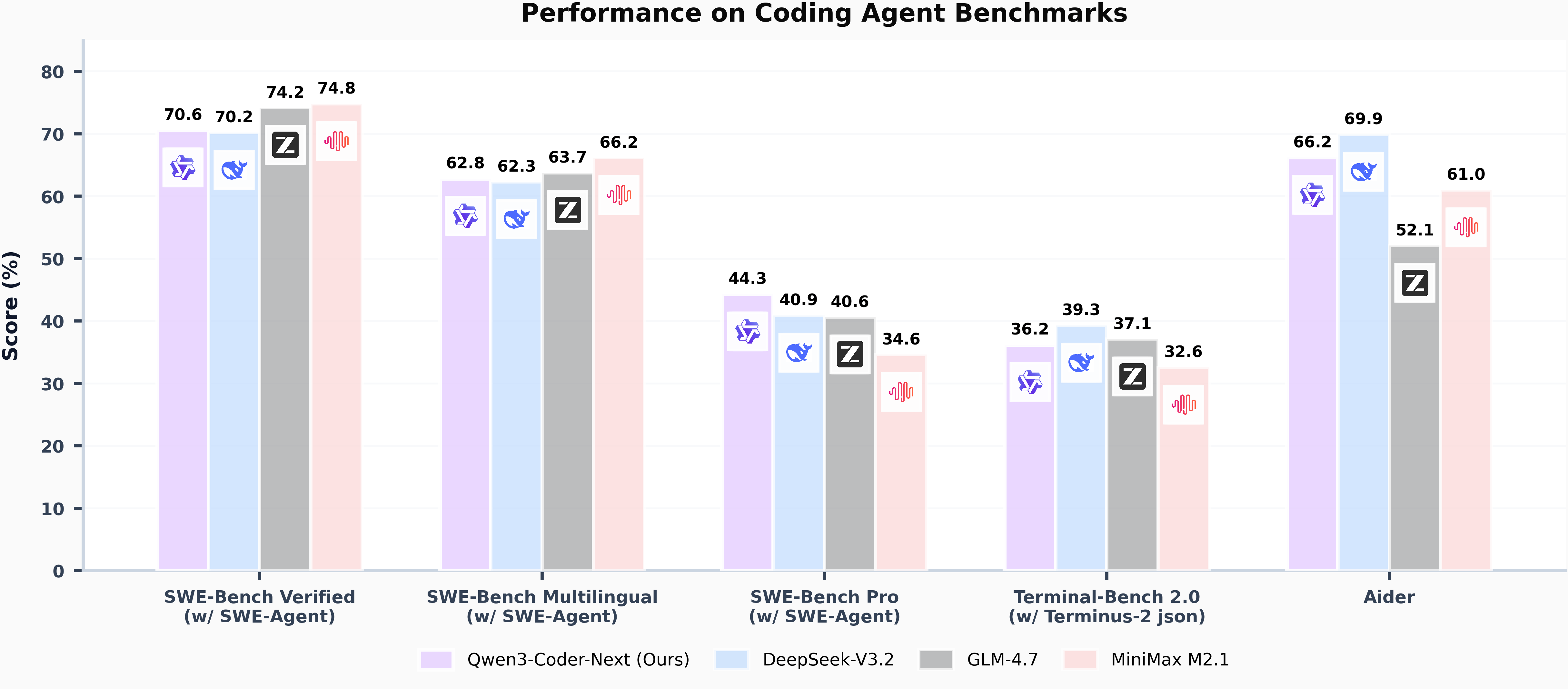

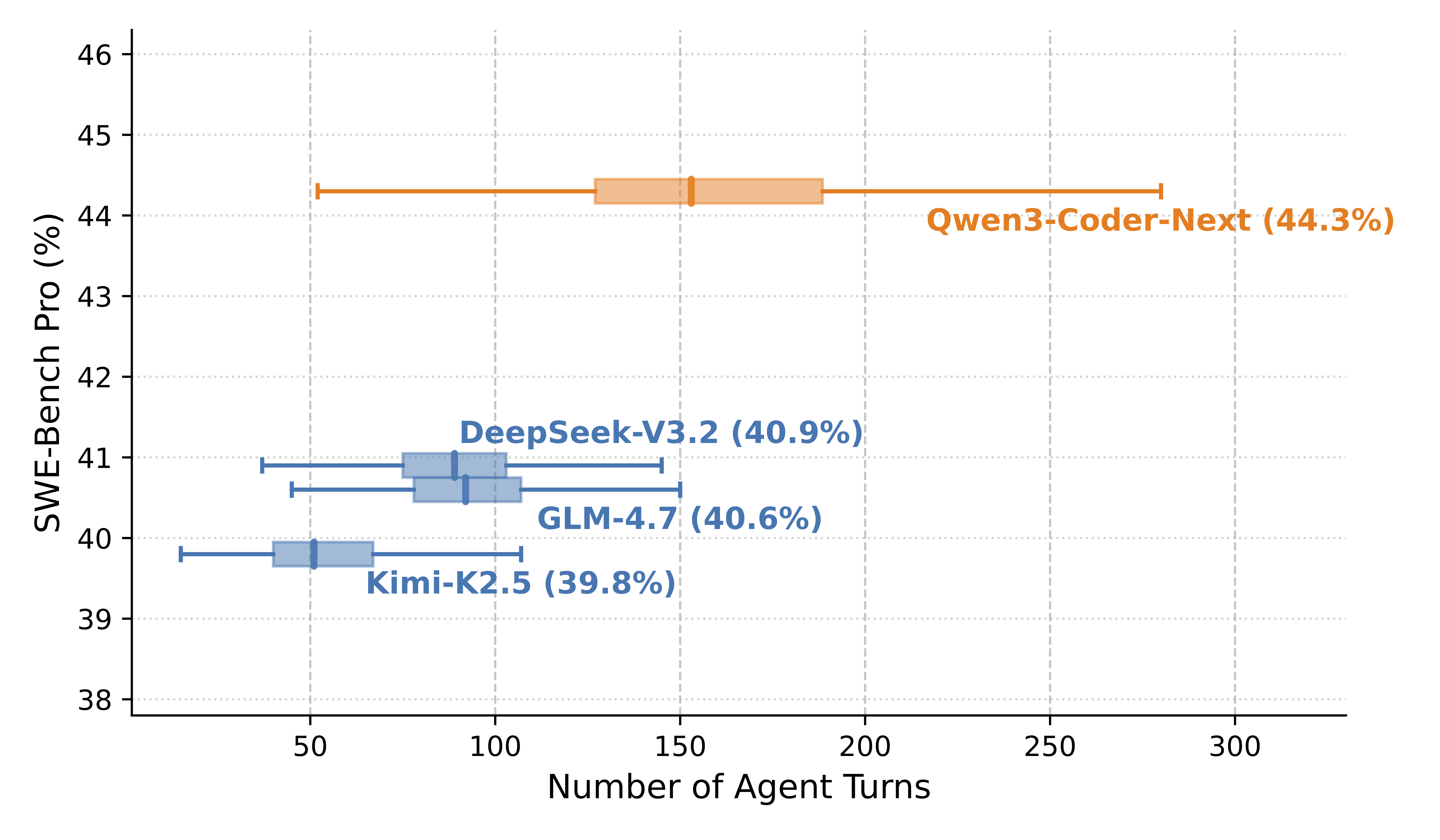

SWE-Agent iskeleti kullanılarak yapılan ölçüt (benchmark) değerlendirmelerinde, Qwen3-Coder-Next aktif parametre sayısına göre dikkate değer bir verimlilik sergiliyor. SWE-Bench Verified'da model yüzde 70,6'lık bir puan elde ederek daha büyük modelleri geride bırkakıyor. Buna yüzde 70,2 puan alan DeepSeek-V3.2 de dahil. Öte yandan Qwen3-Coder-Next aynı ölçütte yüzde 74,2 puan alan GLM-4.7'nin sadece biraz gerisinde kalıyor.

Qwen ekibi model boyutundan ziyade agentic eğitimin ölçeklendirilmesinin, gerçek dünyadaki kodlama ajanı yeteneklerini geliştirmek için temel bir itici güç olduğunu düşünüyor. Ekip, Qwen3-Coder-Next ile sektörde hakimiyet kuran kapalı kaynak kodlama modellerine adeta meydan okuyor.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap