Yaz dönemi birbirinden farklı yapay zeka modellerinin gündeme geldiğini gördük. Apple'dan Meta'ya, OpenAI'dan Mistral'e pek çok şirket yeni yapay zeka modellerini yayına aldı. Cihaz üzerinde çalışabilen küçük yapay zeka modelleri yaygınlığını artırırken, Nvidia ve LG gibi markalar yapay zeka alanındaki varlıklarını güçlendirdi. Gelin, yaz döneminde öne çıkan 10 yapay zeka modeline birlikte bakalım.

Apple'ın 7 milyar parametreli açık kaynak dil modeli: DCLM-7B

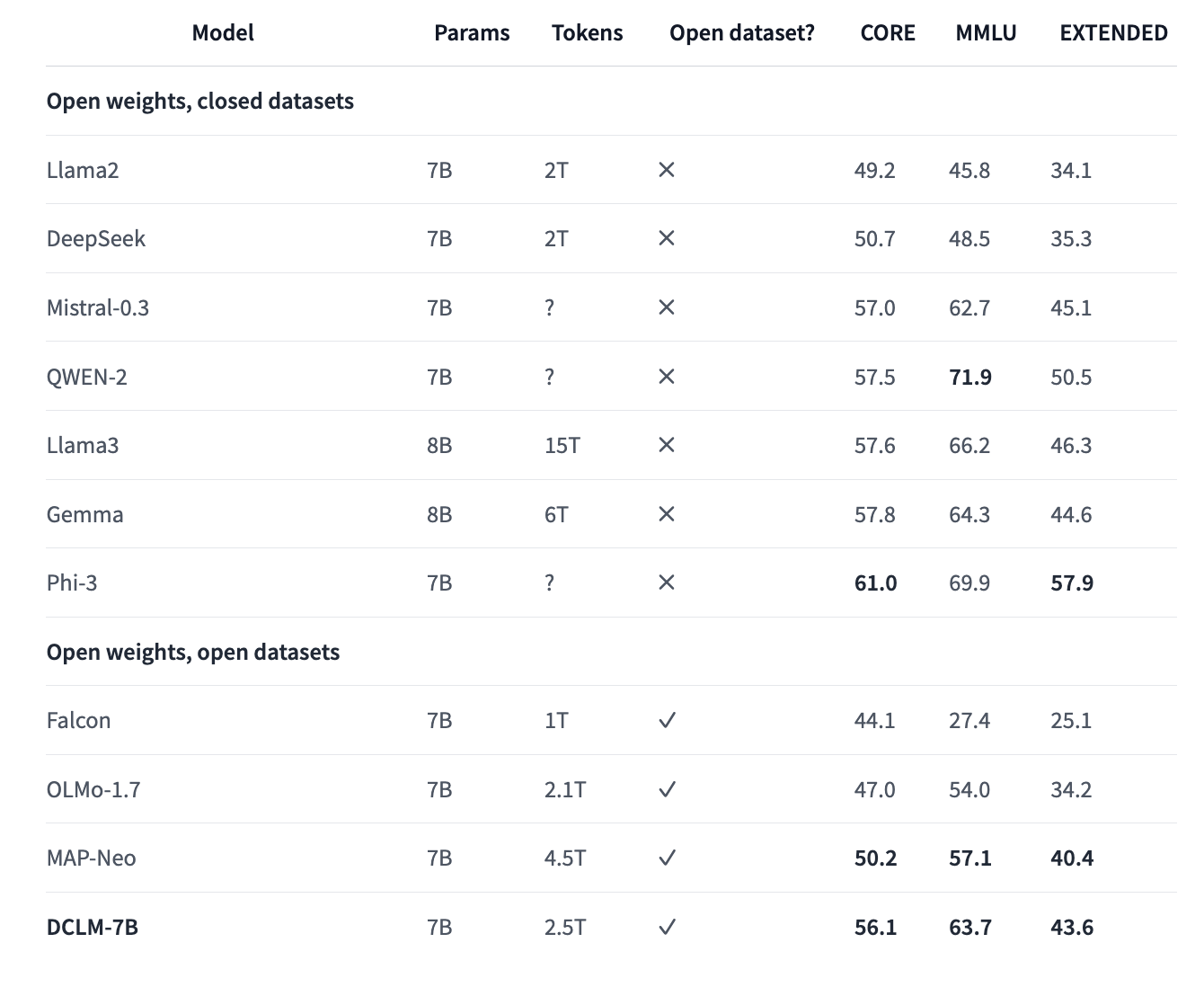

Apple'ın DCLM dil modelleri 7 milyar parametre ve 1.4 milyar parametre olmak üzere iki farklı büyüklüğe sahip. 7 milyar parametreye sahip olan dil modeli, bundan önce en yüksek performansı gösteren DCLM modeli MAP-Neo'yu ölçütlerde yüzde 6.6 geçmekte. Üstelik Apple ekibinin DataComp-LM modeli, bu ölçütleri gerçekleştirmek için yüzde 40 daha az bilgi işlem gücü kullanmakta. Böylece model, açık veri setlerine sahip olanlar arasında en iyi performansı sergilerken, özel veri setlerine sahip olanlarla rekabet etmeyi başardı.

Apple'ın iki modeli de Büyük Çok Görevli Dil Anlama (MMLU) ölçütünde aldığı puanlarla dikkat çekti. Yine de Apple'ın 7 milyar parametreli modeli DCLM-7B, MMLU ölçütünde Llama 3, Gemma, Phi-3 ve Qwen-2 modellerini geride bırakamadı.

Meta'nın 3D varlıklar üreten yeni yapay zeka modeli: Meta 3D Gen

Metin istemlerinden yüksek çözünürlüklü 3D varlıklar üreten Meta 3D Gen, bir dakikanın altında çıktılar sunuyor. Model, istemler aracılığıyla hem oluşturulan hem de sanatçı tarafından üretilen görüntülere yeni dokular ve yüzeyler uygulayabiliyor.

Model, Meta 3D AssetGen ve Meta 3D TextureGen olmak üzere iki bileşenden oluşmakta. Meta 3D AssetGen 3D modeli oluşturuken, Meta 3D TextureGen dokuları hayata geçiriyor.

Ekibin tahminlerine göre; Meta 3D AssetGen modelini kullanarak ilk 3D modeli oluştururken ortalama çıkarım süresi yalnızca 30 saniye. Kullanıcılar daha sonra Meta 3D TextureGen'i kullanarak metin istemleri aracılığıyla mevcut model dokusunu düzeltebilecekleri gibi bu dokuyu yeni bir dokuyla değiştirebilir. Meta 3D TextureGen üzerinde yapılan işlemlerin çıkarım süresi ise yaklaşık 20 saniye. Model ayrıca dokuları 4K çözünürlüğe yükseltebilen bir doku geliştirme ağı da içeriyor. Böylece üst düzey görsel uygulamaların talepleri de karşılanmış oluyor.

Meta'dan mobil cihazlar için büyük dil modeli: MobileLLM

MobileLLM, 350 milyon parametreli versiyonu ile belirli API çağırma görevlerinde doğruluk açısından, çok daha büyük olan 7 milyar parametreli LLaMA-2 modeliyle kıyaslanabiliyor.

Meta'nın Baş Yapay Zeka Bilimcisi Yann LeCun'un paylaştığı bilgiler modelde genişlikten ziyade derinlikten söz etmekte. Yani MobileLLM, genişlik yerine model derinliğine öncelik veriyor. Gömme paylaşımı (embedding sharing) ve gruplanmış sorgu dikkatini (grouped-query attention) uygulayan modelde yeni bir ani blok-bilge ağırlık paylaşımı (immediate block-wise weight-sharing) tekniğinin kullanılması söz konusu.

Böylece MobileLLM, benzer boyuttaki önceki modellere kıyasla yüzde 2,7 ila yüzde 4,3 oranında daha iyi performans gösteriyor. MobileLLM'nin 350 milyon parametreli versiyonu, belirli API çağırma görevlerinde doğruluk açısından çok daha büyük olan 7 milyar parametreli LLaMA-2 modeliyle kıyaslanabilir seviyede. Bu anlamda bazı özel uygulamalar için daha az hesaplama kaynağı kullanan daha küçük modellerin benzer işlevsellik sunabileceğini söyleyebiliriz.

Meta'nın GPT-4o ve Claude 3.5 Sonnet'ye meydan okuyan açık yapay zeka modeli: Llama 3.1 405B

Model, Meta'nın şimdiye kadar yayına aldığı en büyük açık model olarak konumlanıyor. Öte yandan Llama 3.1 405B, 405 milyar parametre ile piyasadaki en büyük açık kaynak yapay zeka modeli değil.

Model, 16 bin Nvidia H100 GPU kullanılarak eğitildi. Meta'nın iddialarına göre; Llama 3.1 405B, OpenAI'ın GPT-4o ve Anthropic'in Claude 3.5 Sonnet modelleri gibi önde gelen modellerle rekabet edebiliyor.

Llama 3.1 405B, AWS, Azure ve Google Cloud gibi bulut platformlarında kullanılabiliyor. Ayrıca ABD merkezli kullanıcılar, WhatsApp ve Meta.ai üzerinden modeli deneyimleyebilir.

Yalnızca metin tabanlı olan model, bir görsel hakkındaki soruları yanıtlayamıyor ancak. PDF gibi belgeleri işleyebiliyor. Kodlama ve temel matematik sorularını yanıtlayabilen model, sekiz dilde faaliyet gösteriyor. Bu diller, İngilizce, Almanca, Fransızca, İtalyanca, Portekizce, Hintçe, İspanyolca ve Tayca olarak karşımıza çıkmakta.

Meta ayrıca diğer iki yeni daha küçük modeli Llama 3.1 8B ve Llama 3.1 70B'yi tanıttı. Bu iki model, şirketin Nisan ayında piyasaya sürdüğü Llama 3 8B ve Llama 3 70B modellerinin güncellenmiş versiyonları olarak konumlanıyor. Her iki modelin de 128 bin token'lık bağlam pencerelerine sahip olduğunu belirtelim. Önceki modellerin bağlamlarının 8 bin token ile sınırlı olduğunu düşünürsek, Meta'nın bu yeni modellerle bağlam penceresinde büyük bir atılım gerçekleştirdiğini söyleyebiliriz.

Tüm Llama 3.1 modelleri, görevleri tamamlamak için üçüncü taraf araçları, uygulamaları ve API'leri kullanabiliyor. Modeller, güncel konularla ilgili soruları yanıtlamak için Brave Search'ten yararlanırken, matematik ve bilimle ilgili sorgular için Wolfram Alpha API'sine erişiyor. Ayrıca model serisi, kodu doğrulamak için bir Python yorumlayıcısından destek alıyor. Şirket, Llama 3.1 modellerinin daha önce görmedikleri bazı araçları bir dereceye kadar kullanabileceğini ifade etmekte.

Llama 3.1 450B modeli GPT-4, GPT-4o ve Claude 3.5 Sonnet ile karşılaştırıldığında genel olarak yüksek performansıyla dikkat çekiyor. Çok Görevli Dil Anlayışı (MMLU) ölçütünde GPT-4o dışında kalan modelleri geride bırakan Llama 3.1 450B, MMLU Pro ölçütünde ise Claude 3.5 Sonnet'nin gerisinde kalıyor. Llama 3.1 450B , Talimat Takip Değerlendirme Veri Seti (IFEval), GSMBK, ARC Challenge, Nexus ve Çok Dilli İlkokul Matematik Ölçütü (Multilingual MGSM) ölçütlerinde GPT-4, GPT-4o ve Claude 3.5 Sonnet'nin önüne geçiyor.

Hugging Face'in mobil cihazlar için küçük dil modeli: SmolLM

SmolLM performansıyla Microsoft, Meta ve Alibaba'nın ürettiği Qwen'in diğer kompakt modellerini geride bırakmaya kararlı.

SmolLM serisi, 135 milyon, 360 milyon ve 1,7 milyar parametre olmak üzere üç farklı boyuta sahip. Az yer kaplamalarına rağmen bu modeller muhakeme ve dünya bilgisi ölçütlerini test eden kıyaslamalarda rakiplerine meydan okuyan sonuçlarla karşımıza çıkıyor.

En küçük model olan SmolLM-135M, daha az token'a sahip olmasına rağmen Meta'nın MobileLM-125M modelinden daha iyi performans gösteriyor. SmolLM-360M ise 500 milyon parametrenin altındaki tüm modelleri geride bırakmayı başarıyor. Buna Meta ve Qwen'in modelleri de dahil. Son olarak platformun amiral gemisi SmolLM-1.7B modelinin, Microsoft'un Phi-1.5, Meta'nın MobileLM-1.5B ve Qwen2-1.5B modellerini birçok kıyaslamada geride bıraktığını görmekteyiz.

OpenAI'ın ChatGPT'ye gelen yeni hafif modeli: GPT-4o mini

OpenAI GPT-4o mini isimli yeni hafif (lightweight) modelini piyasaya sürdü. GPT-4o mini şirketin ChatGPT'yi destekleyen amiral gemisi büyük dil modelinin daha küçük ve daha uygun fiyatlı bir versiyonu olarak karşımıza çıkıyor. Şu anda yalnızca metin ve görüntü ile çalışan GPT-4o mini, ilerleyen dönemde ses ve video gibi diğer içerik türlerini de işleyebilecek.

Bu yeni model, OpenAI'ın şimdiye kadar sunduğu en küçük modeli GPT-3.5 Turbo'ya kıyasla geliştiricilere yüzde 60 daha ucuza mal olacak. Geliştiriciler 1 milyon girdi token'ı başına 5 dolar ve 1 milyon çıktı token'ı başına 15 dolar ödeyecek. Bununla beraber GPT-4o mini'nin saniyede yaklaşık 67 token ileterek GPT-3.5 Turbo kadar hızlı çalışması hedefleniyor.

Ancak bunun da ötesinde GPT-4o mini, ücretsiz ChatGPT kullanıcıları için GPT-3.5 Turbo'nun yerini alacak. Böylece araçtan ücretsiz olarak yararlananlar, temel ChatGPT deneyiminde dikkate değer bir değişim yaşayacak. GPT-3.5 Turbo'yu kullanmaya devam etmek isteyen geliştiriciler, OpenAI'ın API'si aracılığıyla bu modele erişebilecek.

OpenAI'ın belirttiğine göre; GPT-4o mini'nin Kitlesel Çoklu Görev Dil Anlayışı Ölçütünde (MMLU) yüzde 82'lik bir puan elde etti. Söz konusu ölçütün 57 akademik konuda 16 bin çoktan seçmeli soru içerdiğini belirtelim. GPT-4o, MMLU ölçütünde yüzde 88,7 puan almıştı. GPT-4o mini, GPT-4o'yu geçememiş olsa da; aynı ölçütten yüzde 70 puan alan GPT-3,5 Turbo'yu geride bırakıyor.

Mistral AI'ın yeni yapay zeka dil modeli: Large 2

Mistral Large 2, kod üretimi, matematik ve çok dilli destek konularında öne çıkıyor. 128 bin bağlam penceresiyle, kapsamlı veri girdilerinin işlenmesini sağlayarak çeşitli uygulamalarda kullanıcı deneyimini geliştiriyor.

Mistral, Large 2'nin açık modeller için performans ve maliyet çıtasını yükselttiğini ve bunu bir avuç kıyaslama ile desteklediğini söylüyor. Large 2, kod üretimi ve matematik performansında Llama 3.1 405B'yi geride bırakıyor gibi görünüyor ve bunu parametrelerin üçte birinden daha azıyla yapıyor.

Mistral Large 2'yi diğerlerinden ayıran şey, makul ancak yanlış bilgiler ürettiği durumları en aza indirmeye odaklanması. Zira Mistral, Large 2'yi bilmediği şeyleri fark etmesi için özel olarak eğitti, bu da aslında oldukça önemli bir gelişme.

Modelin 128 bin token'lık bir penceresi var, bu da Large 2'nin tek bir istemde çok fazla veri alabileceği anlamına geliyor. Mistral'in yeni modeli ayrıca gelişmiş çok dilli destek de içeriyor. Large 2, İngilizce, Fransızca, Almanca, İspanyolca, İtalyanca, Portekizce, Arapça, Hintçe, Rusça, Çince, Japonca ve Korece'nin yanı sıra 80 kodlama dilini de anlıyor.

Nvidia ve Mistral AI'ın kurumsal yapay zekayı bilgisayarlara taşıyan yeni modeli: Mistral-NeMo

Belli bir süre dünyanın en değerli şirketi olmayı başaran Nvidia, Avrupa'nın yapay zeka yıldızı Mistral AI ile gücünü birleştirerek yeni yapay zeka modeli Mistral-NeMo'yu tanıttı. Bu yeni model, 12 milyar parametre ve 128 bin token'lık geniş bir bağlam penceresine sahip. Güçlü yapay zeka yetenekleriyle dikkat çeken modelin doğrudan iş bilgisayarlarında çalışması hedefleniyor.

Nvidia'nın paylaştığı bilgilere göre model, NVIDIA NeMo'nun bir parçası olan Megatron-LM kullanılarak, NVIDIA AI mimarisinden oluşan DGX Cloud üzerinde 3.072 H100 80GB Tensor Core GPU ile eğitildi.

Küresel, çok dilli uygulamalar için tasarlanan model, özellikle İngilizce, Fransızca, Almanca, İspanyolca, İtalyanca, Portekizce, Çince, Japonca, Korece, Arapça ve Hintçe'de güçlü. Mistral NeMo, 100'den fazla dil üzerinde eğitilmiş Tiktoken tabanlı yeni bir tokenizer olan Tekken'i kullanıyor. Böylece model, önceki Mistral modellerinde kullanılan SentencePiece tokenizer'a kıyasla doğal dil metinlerini ve kaynak kodunu daha verimli bir şekilde sıkıştırıyor. Tekken, Llama 3 tokenizer ile karşılaştırıldığında tüm dillerin yaklaşık yüzde 85'i için metin sıkıştırmada daha yetkin.

Gemma 2 9B ve Llama 3 8B ile karşılaştırılan Mistral-NeMo, Llama 3 8B'yi tüm ölçütlerde, Gemma 2 9B 'yi ise MMLU (Kitlesel Çoklu Görev Dil Anlayışı) ölçütü dışında tüm ölçütlerde geride bırakıyor.

LG'nin yeni açık kaynak yapay zeka modeli: Exaone 3.0

Yapay zeka araştırmalarına odaklanan LG AI Research, açık kaynak yapay zeka modeli Exaone 3.0'ı duyurdu. 7,8 milyar parametreli modelin, hem Korece hem de İngilizce dil görevlerinde başarılı olduğu belirtiliyor.

Özellikle İngilizce dilinde gerçek dünya kullanım senaryoları, matematik ve kodlama kategorilerinde Llama, Gemma, QWEN, Phi ve Mistral'in yakın parametreli modellerine kıyasla daha iyi performans gösterdiği görülmekte. Korece'de ise yalnızca gerçek dünya kullanım senaryoları ve genel kategorisinde üstün performanstan bahsediliyor.

LG'nin paylaştığı bilgilere göre Exaone 3.0, önceki modele kıyasla çıkarım süresinde yüzde 56, bellek kullanımında yüzde 35 ve operasyonel maliyetlerde yüzde 72 azalma sağladı. Model, patentler, kodlar, matematik ve kimya ile ilgili 60 milyon profesyonel veri üzerinde eğitildi. Bununla birlikte yıl sonuna kadar çeşitli alanlarda 100 milyon vakaya genişletilmesi planlanıyor. Öte yandan modelin şu an için çeşitli ölçütlerde diğer açık kaynak modelleri geride bırakamadığını belirtmekte fayda var.

Elon Musk'ın yapay zeka şirketi xAI'ın Grok-2 ve Grok-2 mini modelleri

Yeni Grok modeli artık X sosyal ağında görüntüler oluşturabiliyor, ancak Grok erişimi şu anda X'teki Premium ve Premium+ kullanıcılarıyla sınırlı. Grok-2'nin özellikle sohbet, kodlama ve muhakeme alanlarında daha ileri düzey yetenekler sunduğunu söylemek mümkün. Grok'un bu görüntüleri oluşturmak için Black Forest Labs tarafından geliştirilen FLUX.1'i kullandığını gösteriyor.

Yapay zeka şirketi her iki modeli de bu ay içinde kurumsal API'ı aracılığıyla geliştiricilerin kullanımına sunmayı planlıyor. Kullanıcılar tarafından üretilen ilk görüntüler, Grok'un görüntü oluşturma özelliğinin siyasi figürlerin görüntülerini oluşturma konusunda herhangi bir korumaya sahip olmadığını gösteriyor.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap