Meta'nın yapay zeka araştırmacıları, kelimelerden öğrenmek yerine videodan öğrenen Video Joint Embedding Predictive Architecture (V-JEPA) isimli yeni bir model yayınladı. Günümüzün büyük dil modellerine benzer bir şekilde eğitilmesine rağmen modelin videodan öğrenmesi farklılık yaratıyor.

Meta'nın FAIR (temel yapay zeka araştırması) grubunu yöneten Yann LeCun yapay zeka modellerinin aynı maskeleme tekniğini video görüntüleri üzerinde kullanmaları halinde daha hızlı öğrenebileceklerini öne sürüyor. LeCun, şirketin amacının, insanlar gibi öğrenebilen gelişmiş makine zekası oluşturmak olduğunu dile getiriyor.

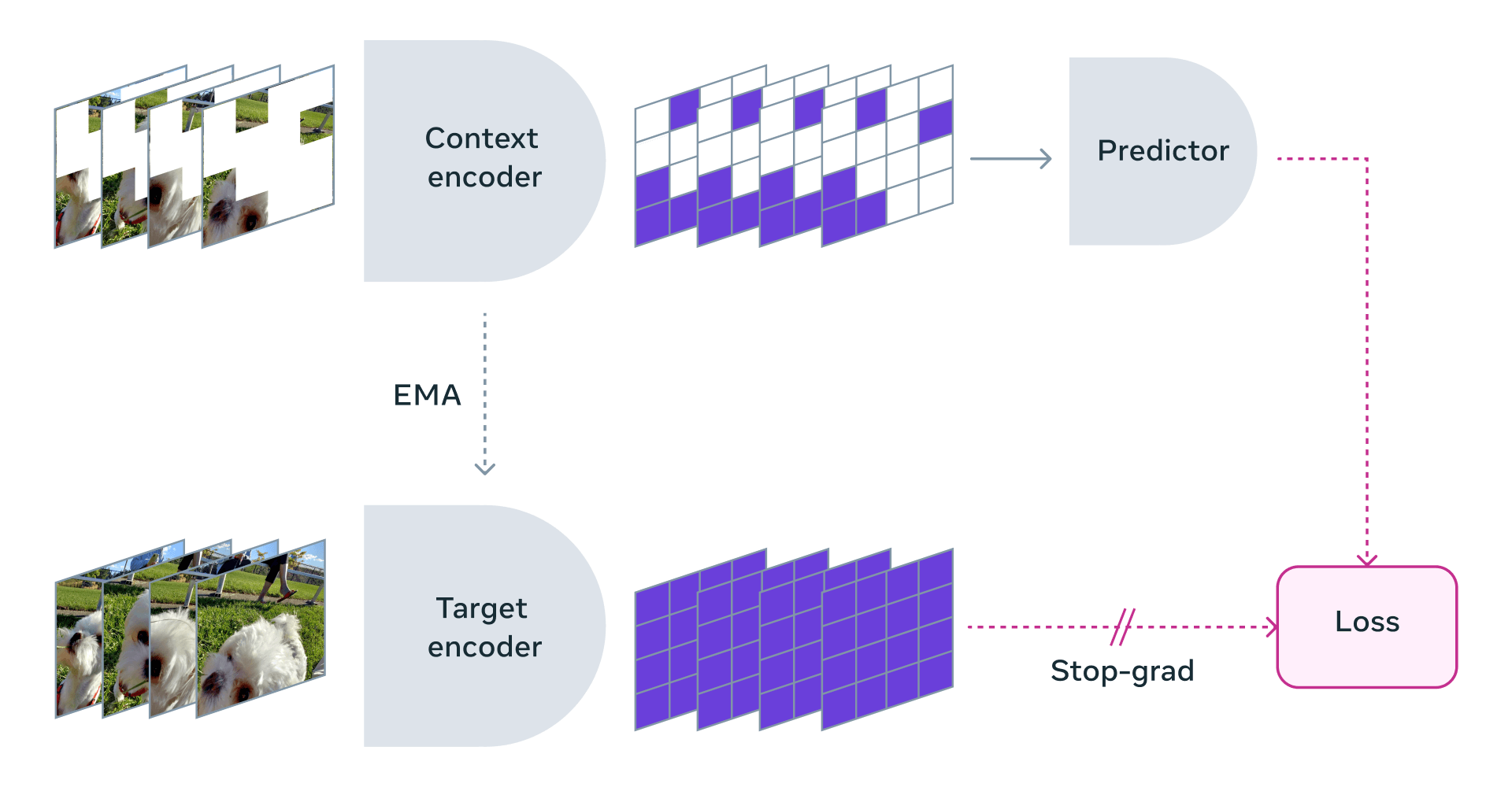

Paylaşılan bilgilere göre bu model, etiketlenmemiş videoyu işleyerek ve ekranın karartıldığı birkaç saniye boyunca ekranın belirli bir bölümünde muhtemelen ne olduğunu anlayarak öğreniyor.

Bu arada V-JEPA'nın üretimsel bir model olmadığını belirtmekte fayda var. V-JEPA, dahili bir kavramsal dünya modeli geliştiriyor. Meta araştırmacılarının aktardıklarına göre; video maskeleme kullanılarak yapılan ön eğitimden sonra V-JEPA nesneler arasındaki son derece ayrıntılı etkileşimleri tespit etme ve anlama konusunda başarılı oldu.

Meta AI lideri Jérôme Pesenti ve Meta AI Research'ün yönetici direktörü Joelle Pineau bundan yaklaşık iki yıl önce yapay zekanın metaverse'ü nasıl etkileyeceğini aktarırken yapay zekada "dünya modeli" kavramını da gündeme getirmişti. O dönemde ikilinin anlattığı ve artırılmış gerçeklik gözlüklerinde kullanılması planlanan dünya modeli, gözlüğün dışındaki dünyayı görsel-işitsel olarak anlayabilecek, ancak daha sonra cihazın kameraları ve mikrofonları aracılığıyla kullanıcının dünyasının benzersiz özelliklerini çok hızlı bir şekilde öğrenebilecekti.

LeCun, mevcut LLM'lerin görüntüler ve sesler aracılığıyla öğrenememesinin yapay genel zekaya (AGI) doğru ilerlemeyi yavaşlattığını savunuyor.

Meta'nın V-JEPA için sonraki adımı ise videoya ses eklenmesi. Böylece modele öğrenmesi için yepyeni bir veri boyutu sağlanacak. Meta, V-JEPA modelini ticari olmayan lisansı Creative Commons altında yayınladı. Böylece araştırmacılar, bu modeli deneyebilecek.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap