Hemen hemen herkesin yüz hareketlerinin, konuşma ve ses klipleriyle senkronize edilebileceğini söyleyen Microsoft araştırmacıları, yapay zekayı kullanarak konuşan insan animasyonları üretmeye başladı. Aslında bu çok da şaşırtıcı bir bilgi değil, zira "deepfake" videoları artık hayatımızın her alanında karşımıza çıkıyor. Bu yöntemle eğlenceli videolar oraya çıksa da kimi zaman siyasetçilerin demeçlerinin çarpıtılmasına da neden oluyor.

Gelişen teknoloji, deepfake'in hiçbir zaman ortadan kalkmayacağının kanıtı olabilir. Çünkü Microsoft gibi dünyanın en önemli teknoloji şirketlerinden biri "deepfake" olarak adlandırmasa da yeni gelişmeyle bu alana adım atmış gibi duruyor. Üstelik Microsoft bu alanda tek değil.

Geçtiğimiz haziran ayında Samsung araştırmacıları da bir kişinin kaşlarını, ağzını, kirpiklerini ve yanaklarını birebir olarak canlandırabilen uçtan uca bir modeli ayrıntılarıyla anlatmışlardır. Bundan sadece birkaç hafta sonra Udacity, ses anlatımından ders videolarını otomatik olarak üreten bir sistemi tanıtmıştı. İki yıl önce de Carnegie Mellon araştırmacıları yüz hareketlerini bir kişiden diğerine aktarabilmeye imkan veren yaklaşımı açıklayan bir bildiri yayınlamışlardı.

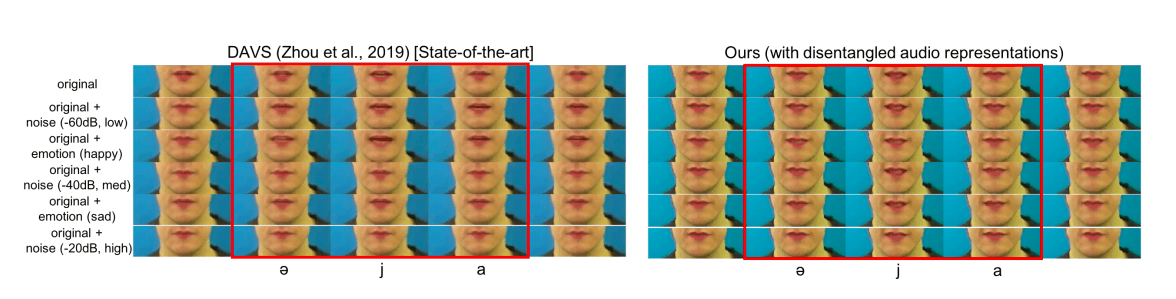

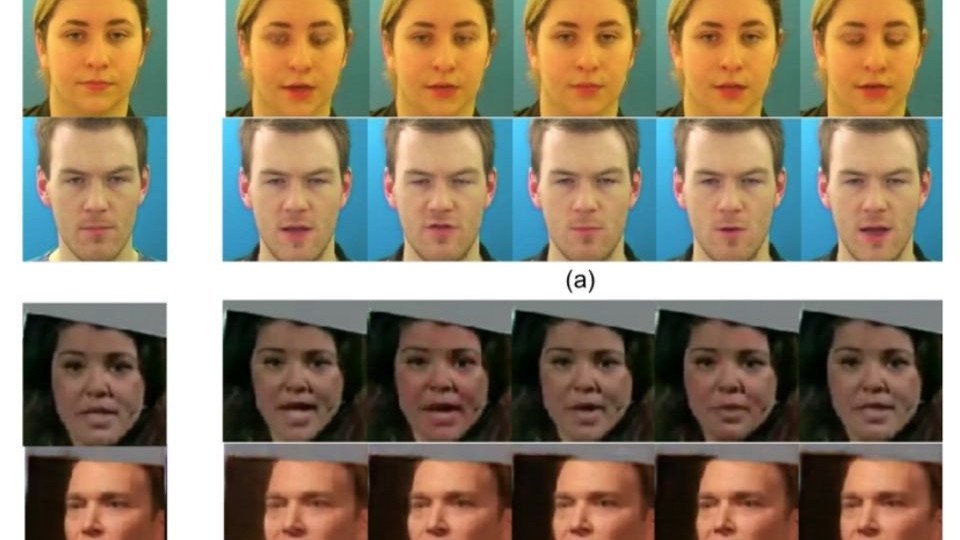

Microsoft Araştırma ekibi, bunlara ve diğer çalışmalara dayanarak, ses odaklı konuşan kafa animasyonlarının kalitesini artırdığını iddia ettikleri bir teknik ortaya koydu. Önceki insan kafası oluşturma yaklaşımları, nötr bir tonda temiz ve nispeten gürültüsüz bir ses gerektiriyordu. Ancak araştırmacılar yeni araştırmayla birlikte, ses dizilerini fonetik içerik ve arka plan gürültüsü gibi faktörlere ayıran yöntemlerinin gürültülü ve duygusal açıdan zengin veri örneklerini genelleştirebileceğini söylüyorlar.

İnsan konuşmalarının varyasyonlarla dolu olduğunu söyleyebiliriz. Çünkü farklı insanlar, aynı kelimeyi, farklı sürelerde, tonda vb. farklı bağlamlarda söyleyebiliyorlar. Fonetik içeriğe ek olarak, yapılan konuşma konuşmacının duygusal durumu, kimliği (cinsiyet, yaş, etnik köken) ve kişiliği hakkında da bolca bilgi veriyor. Microsoft yeni araştırmasıyla yaptığı işi, performansı ses gösterimi öğrenme perspektifinden iyileştirmenin ilk yaklaşımı olarak açıklıyor.

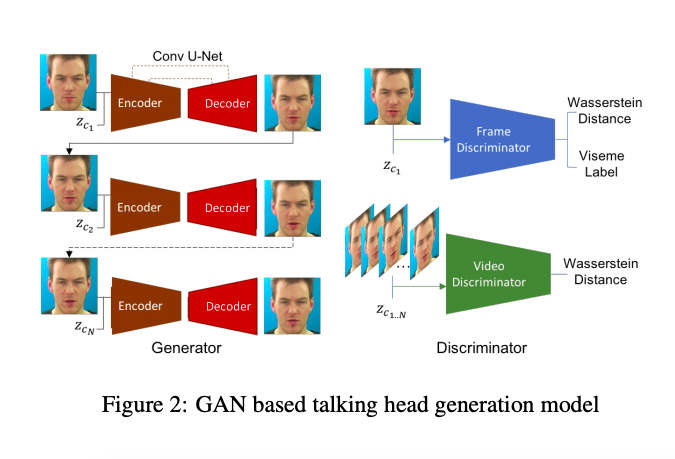

Önerilen tekniğin altında, gizli gösterimleri öğrenen değişken bir otomatik kodlayıcı (VAE) bulunuyor. Giriş ses dizileri, VAE tarafından içeriği, duyguyu ve diğer varyasyon faktörlerini kodlayan farklı gösterimlere dönüştürülüyor. Giriş sesine dayanarak, yüzden harekete geçmek için giriş yüz görüntüleri ile birlikte bir video üretecine beslenen dağıtımdan bir dizi içerik gösterimi örnekleniyor. Böylelikle o yüze uygun olabilecek olası bir ses çıkıyor.

Ekip, yaklaşımlarının temiz, tarafsız sözlü ifadeler için diğer yöntemlerle birlikte tüm ölçütlerde performans açısından eşit olduğunu söylüyor. Dahası, tüm duygusal spektrumda tutarlı bir şekilde performans gösterebildiğini ve kafa kafaya konuşma için mevcut tüm modern yaklaşımlarla uyumlu olduğunu belirtiyorlar.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap