Geçtiğimiz aylarda oldukça ilginç bir güzellik yarışması yapıldı. "İnsan güzelliği" üzerine yapılan yarışmalardan biraz farklılaşmış olan bu yarışmanın temeli yapay zeka ve jüriler 5 adet robot yazılımdı. 100'den fazla ülkeden 6.000 katılımcının fotoğraf göndererek katıldığı yarışma gerçekten ilginç çıkarımlara sahne oldu.

5 yapay zeka yazılımının her birinin farklı kriterleri bulunuyordu:

- Yaş gruplarına göre kırışıklık miktarına göre puanlama

- Sivilce ve lekelerin miktarına göre puanlama

- Kendi ırklarındaki modellere göre benzerliklerin incelenmesi ve puanlanması

- Yüzün simetrisine göre puanlama

- Gerçek yaş ve görünen yaş arasındaki farkın tahmini ve puanlanması

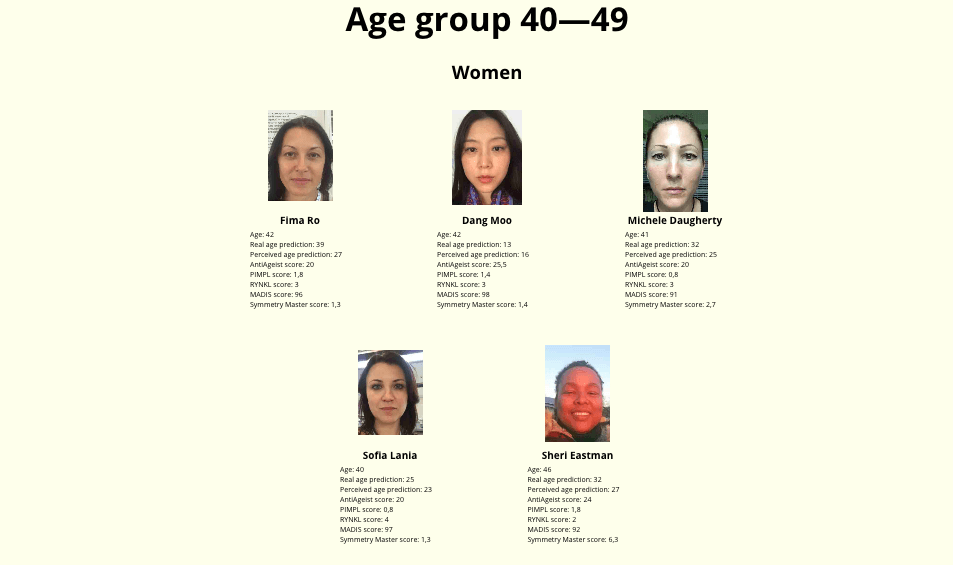

Birbirinden karmaşık algoritmalar sonucu 44 finalist belirlendi. Finalistler içerisinde 5 adet Asya kökenli kişi vardı ve sadece 1 adet siyah tenli finalist vardı. Bir başka deyişle 44 finalistin 43'ü beyaz tenli ve sadece 1'i koyu tenliydi.

Oldukça düşündürücü sonuçlar bize insan önyargılarının yapay zekayı nasıl etkilediğini oldukça açık ve net bir şekilde gösteriyor. Microsoft'un ırkçı söylemler nedeniyle kapattığı yapay zeka botu "Tay" bu seçimleri yapsa ancak bu kadar olurdu sanırım.

İstenmeden yapılan bu ve beneri testler sıklıkla "kötü" sonuçlar getiriyor. Yapay zeka teknolojilerinin henüz bebeklik döneminde olduğunu düşünecek olursak bu alanda yapılabilecek oldukça fazla düzenleme olduğunu net bir şekilde söyleyebiliriz. Fakat asıl "insanlık" olarak henüz almamız gereken çok yol var gibi görünüyor.

Beauty.AI'nin başındaki bilim adamlarından Alex Zhavoronkov, "Microsoft tarafından desteklenen Beauty.AI'nin güzellikleri değerlendiren algoritması oluşturulurken çok büyük fotoğraf setlerine dayanıyordu. Bu tür sonuçların çıkmasının bir kaç nedeni olabileceği gibi cazibe standartlarını oluşturmak için kullandığımız verilerin azlığı da buna neden olmuş olabilir" diyor.

Tabi ki "ırkçı" yapay zeka sadece bu güzellik yarışmasında ortaya çıkan bir durum değil. Buna benzer bir çok örnek daha önceleri de yaşanmış ve problemin önüne geçilebilmesi için erkenden önlemlerin alınması gerekiyor.

2016 yılı başlarında ProPublica tarafında yapılan bir soruşturma, gelecekteki suçluları öngörebilmek için kullanılan yazılımların siyahlara karşı önyargılı olduğunu ve bunun da onlara karşı çok daha sert yaptırımlara neden olabileceğini ortaya koydu.

Yapay zekadaki bu sorunlar genellikle eldeki datanın yetersizliği ve tabi ki kirliliği ile ilgili. Yani ne kadar sağlıklı datalara sahip olursak o kadar tarafsız sonuçlar elde edebiliriz. Dünyanın bir çok bölgesinde yaşayan azınlıkların geri kalan karşısında yeteri dataya sahip olmaması oldukça doğaldır. Bu nedenle özel datalar girilmesi ve filtreleme sistemleri kullanılması, bu önyargılı sonuçların önüne geçilmesini sağlayabilir.

Yaptığımız her bir arama ve tıkladığımız her sonuç, geleceğin yapay zekasına bir yönlendirme olarak gidiyor. Irkçı bir arama yaptığınız zaman veya karşınıza çıkan ırkçılık kokan bir içeriği fazlasıyla benimsediğiniz zaman (sitede fazla zaman geçirmek, beğenmek, paylaşmak, kayıt etmek gibi) bunlar büyük veri setlerinde tanımlanıyor ve karşımıza ırkçı sonuçlar olarak çıkabiliyor.

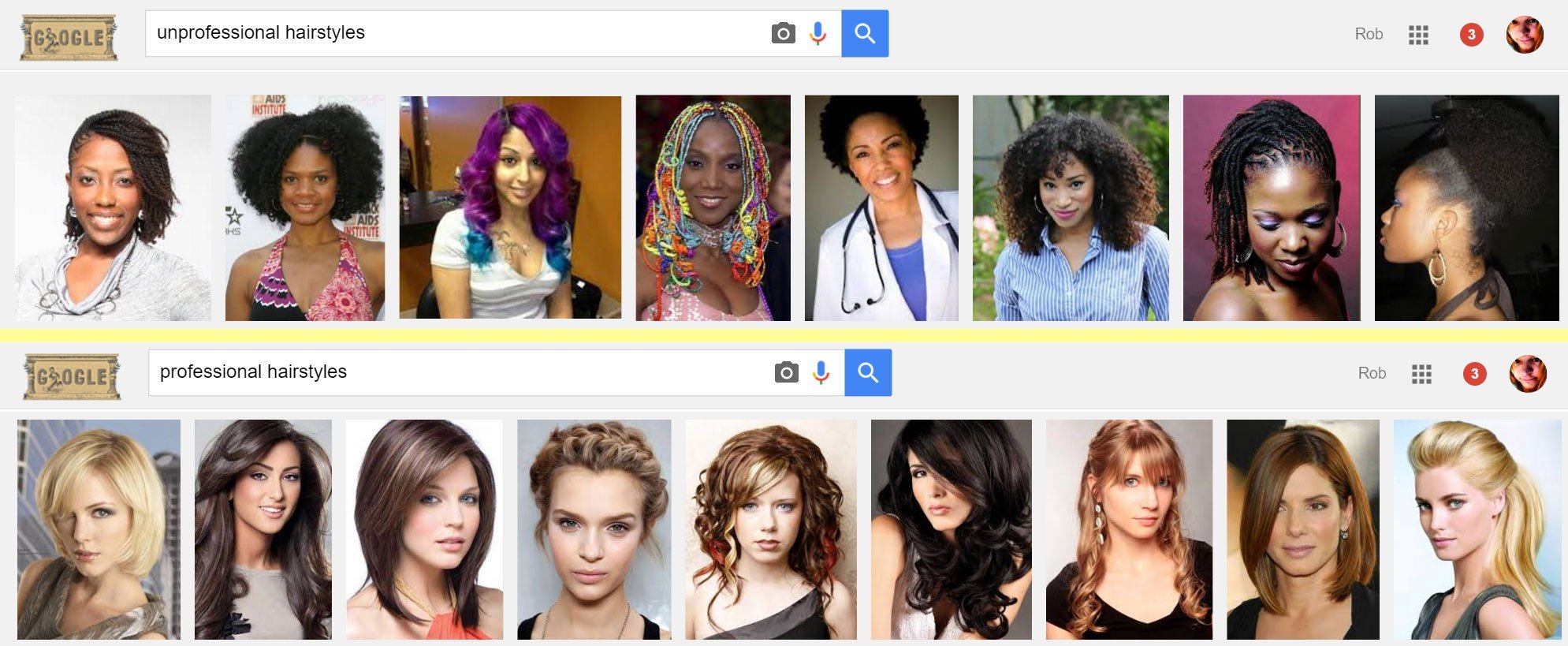

Bu konuda çok güzel bir örneği yine 2016 yılında yapılan bir Google araması gözler önüne sermiş.

Google'a "profesyonel saç şekilleri" ve "profesyonel olmayan saç şekilleri" araması yapan bir blog yazarı, oldukça ilginç bir sonuçla karşılaşmış. Profesyonel saç şekillerinin tamamında beyaz kadınlar çıkarken, profesyonel olmayan saç şekillerinde siyah kadınlar çıkmış. Üstelik çoğu gayet normal saç şekline sahip. Tüm bunlar, bizim beslediğimiz algoritmaların tekrar bize yansıması.

Sanırım yapay zekayı geliştirmeden önce insanlık olarak bir adım daha ileriye gitmemiz gerekiyor. Bilinçli olarak olmasa bile hala bilinç altımızda yatan önyargıların sonuçları, gelecekte çok daha yıkıcı olabilir.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap