Google, dün Ironwood adlı yedinci nesil yapay zeka çipini tanıttı. Şirketin belirttiğine göre; Ironwood, yapay zeka uygulamalarının performansını hızlandırmak için tasarlandı. Google'ın yedinci nesil tensör işleme birimi (TPU) olan Ironwood, yapay zeka modellerini çalıştırmak üzere çıkarım için optimize edilmiş ilk çip olma özelliğini taşıyor.

Google Cloud Başkan Yardımcısı Amin Vahdat Ironwood'un şirketin şimdiye kadarki en güçlü, yetenekli ve enerji tasarruflu TPU'su olduğuna dikkat çekerken, düşünen, çıkarımsal yapay zeka modellerini büyük ölçekte güçlendirmek için özel olarak tasarlandığını ifade etti. Şirketin belirttiğine göre; TPU'nun mimarisi, çip üzerindeki veri hareketini ve gecikmeyi en aza indirecek şekilde tasarlandı. Bu sayede Ironwood'un güç tasarrufu sağladığını söylemek mümkün.

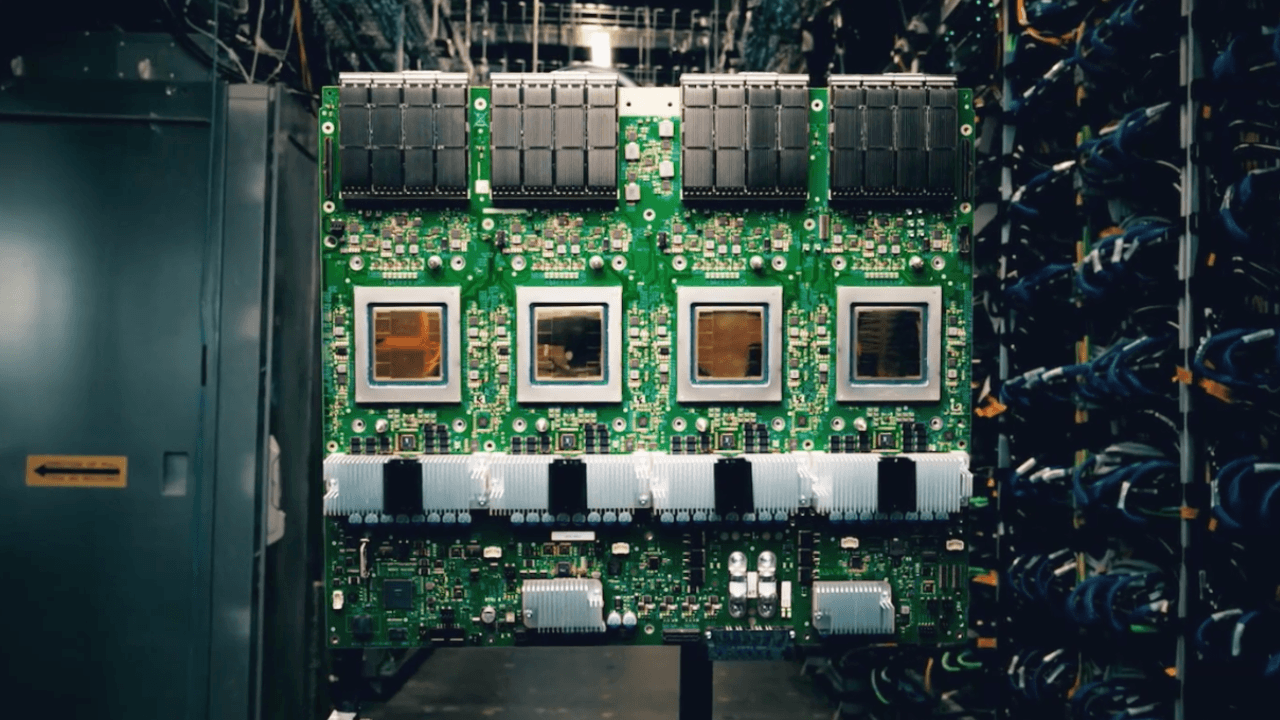

Google'ın kurum içinde gerçekleştirdiği kıyaslamalarına göre Ironwood en yüksek seviyede 4.614 TFLOP işlem gücü sunabiliyor. Ayrıca her bir çip, 7,4 Tbps'ye yaklaşan bant genişliği ile 192 GB özel RAM'e sahip olmasıyla öne çıkıyor. 192 GB kapasite Google'ın son nesil Trillium TPU'sundan altı kat daha fazla. Bellek bant genişliğinin ise 4,5 kat iyileşme gösterdiğini belirtmekte fayda var. Bununla birlikte Ironwood'un SparseCore'a sahip olduğunu belirtelim. SparseCore, gelişmiş sıralama ve öneri iş yüklerinde yaygın olarak kullanılan veri türlerini işlemek için geliştirilmiş özel bir çekirdek.

Ironwood'un bu yılın sonlarına doğru Google Cloud müşterilerine sunulması planlanıyor. Ironwood, 256 çipli bir küme ve 9.216 çipli bir küme olmak üzere iki konfigürasyonda sunulacak. Yani Ironwood, 9.216 adede kadar sıvı soğutmalı çiplerden oluşan kümeler halinde çalışabilecek. Söz konusu çipler, yeni geliştirilmiş Yongalar Arası Bağlantı (ICI) aracılığıyla birbirleriyle doğrudan iletişim kuracak. Amin Vahdat'ın paylaştığı bilgilere göre; Google, Ironwood'u yakın gelecekte Google Cloud'daki modüler bir bilgi işlem kümesi olan AI Hypercomputer ile entegre etmeyi planlıyor.

Günümüzde pek çok teknoloji devinin kendi yapay zeka hızlandırıcılarını hayata geçirdiğini görüyoruz. Amazon, AWS üzerinden kullanılabilen Trainium, Inferentia ve Graviton işlemcilerine sahipken, Microsoft, Maia 100 AI çipi ile dikkat çekiyor. Son dönemde OpenAI ve Meta'nın da kendi çiplerini geliştirmeye odaklandığını da ekleyelim.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap