Apple'ın yapay zeka teknolojilerine odaklanan Apple Intelligence araştırma ekibi, iki yeni küçük dil modeli yayınladı. Küçük dil modellerinin popüler olduğu bu dönemde Apple'ın da bu furyaya katılması dikkat çekti. Küçük olmasına rağmen yüksek performans gösteren bu dil modelleri, üretken yapay zeka modellerini eğitmek için kullanılılıyor.

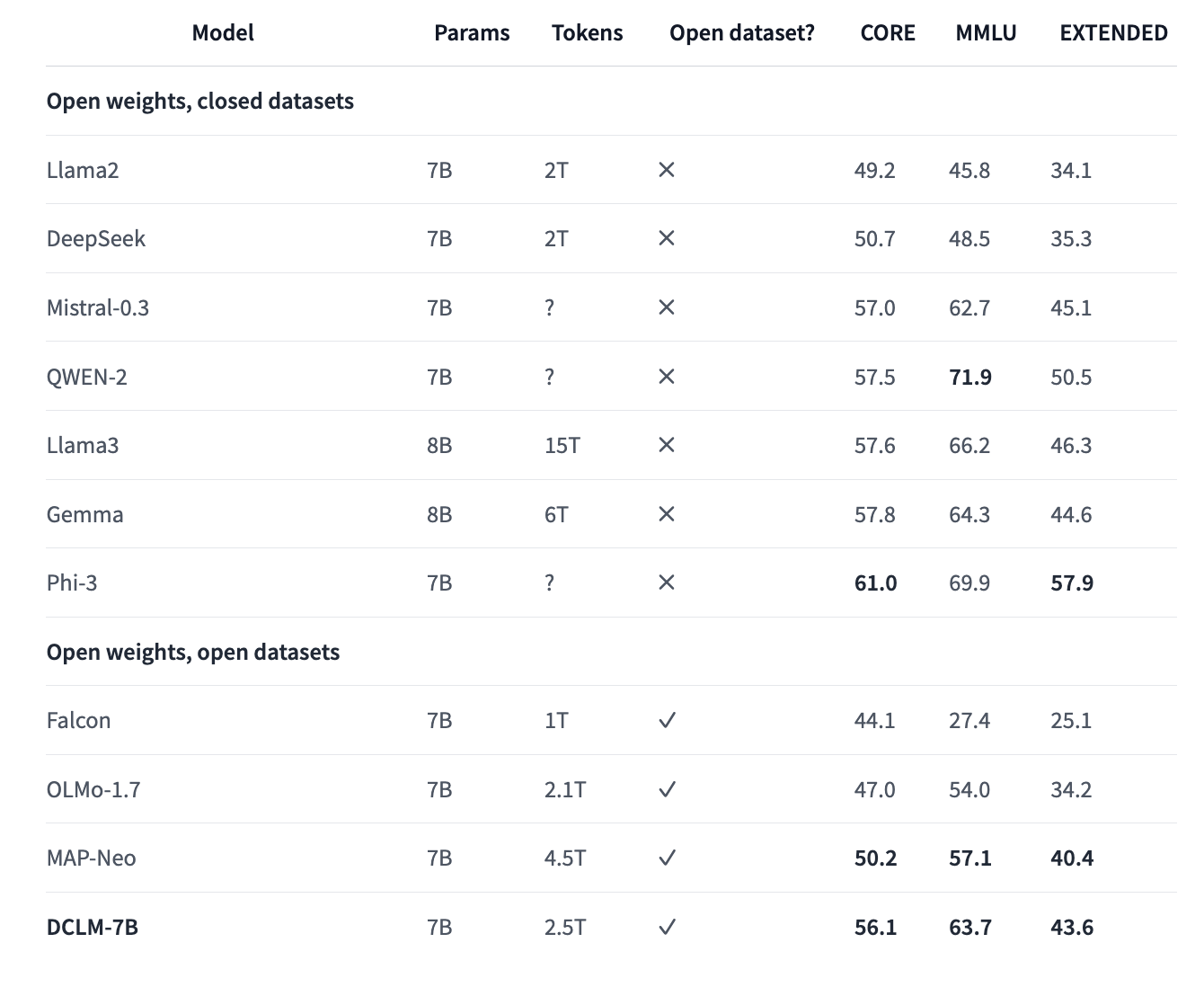

Apple'daki Makine Öğrenimi ekibinin açık kaynaklı DataComp for Language Models (DCLM) projesi kapsamında ürettiği iki model, Llama 3 ve Gemma gibi diğer önde gelen eğitim modelleriyle yarışıyor. Bazı kriterlerde bu daha küçük modellerle benzer performans gösteren Apple'ın küçük dil modelleri, bazı ölçütlerde ise onları geçmeyi başarıyor.

Bu arada Harvard ve Stanford gibi okulların ve Toyota gibi şirketlerin yer aldığı DataComp for Language Models projesinin en etkili veri iyileştirme stratejilerine odaklandığını belirtelim.

Apple'ın yayınladığı dil modelleri, standart bir framework sağlayarak ChatGPT ya da Claude gibi yapay zeka motorlarını eğitmek için kullanılıyor. Bu bağlamda modeller, bir mimari, parametreler ve veri kümelerinin filtrelenmesini içeriyor. Veri kümelerinin filtrelenmesiyle, yapay zeka motorlarının yararlanabileceği daha yüksek kaliteli veriler sağlanıyor.

Apple'ın yeni modelinin performansı

Apple'ın DCLM dil modelleri 7 milyar parametre ve 1.4 milyar parametre olmak üzere iki farklı büyüklüğe sahip. 7 milyar parametreye sahip olan dil modeli, bundan önce en yüksek performansı gösteren DCLM modeli MAP-Neo'yu ölçütlerde yüzde 6.6 geçmekte. Üstelik Apple ekibinin DataComp-LM modeli, bu ölçütleri gerçekleştirmek için yüzde 40 daha az bilgi işlem gücü kullanmakta. Böylece model, açık veri setlerine sahip olanlar arasında en iyi performansı sergilerken, özel veri setlerine sahip olanlarla rekabet etmeyi başardı.

Apple'ın iki modeli de Büyük Çok Görevli Dil Anlama (MMLU) ölçütünde aldığı puanlarla dikkat çekti. Yine de Apple'ın 7 milyar parametreli modeli DCLM-7B, MMLU ölçütünde Llama 3, Gemma, Phi-3 ve Qwen-2 modellerini geride bırakamadı.

Apple ekibinin yayınladığı bu modellerin, gelecekte herhangi bir Apple ürününde kullanılmak üzere tasarlanmadığını da belirtelim. Topluluk araştırma projeleri olarak konumlanan modeller, yapay zeka modellerini eğitmek için kullanılan veri kümelerinin etkin bir biçimde iyileştirilmeyi amaçlıyor. Bu anlamda Apple'ın araştırma ekibi ayrıca çeşitli veri iyileştirme tekniklerinin etkisinin yanı sıra model tabanlı kalite filtreleme stratejilerini de araştırdı. Geliştiriciler modellere Hugging Face üzerinden erişebilir.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap