Bir süredir droneların reklamcılık ve film sektöründe yaygın olarak kullanılmaya başlandığı sizin de dikkatinizi çekmiştir. Dronelar objeleri takip etmek ve yakalamak açısından güzel bir perspektif sunsa da; çekim sürecinde devamlılık açısından bazı problemler yaratabiliyor.

Pozisyonları, hızları ve açıları doğru ayarlanmış olsa dahi dronelar, çekim esnasında aynı sahne için farklı bir yol izlemeyi tercih edebiliyor. Carnegie Mellon Üniversitesi ve Facebook tarafından birlikte geliştirilen bir framework ise tam olarak bu soruna çözüm üretiyor.

Framework nasıl çalışıyor?

Framework için yayınlanan bilimsel makale "Etkileyici robot sinematografisi için anlamsal bir kontrol alanı öğrenmek" başlığıyla dikkat çekiyor. Kullanıcılar drone tarafından yapılacak çekimleri "heyecanlı", "eğlenceli" ve "genel çekim" etiketleriyle tanımlayabiliyor. Böylece yapılan tüm çekimler belli bir standart içinde gerçekleştirilmiş oluyor.

Video çekimleri genellikle yüksek maliyetlere sahip. Kısa bir reklam filmi çekmek için en düşük maliyetlerle hareket etseniz dahi bin 500 dolar - 3 bin 500 dolar arası bir bütçe ayırmanız gerekiyor. Küçük işletmeler ve startuplar çekimler için kurum içinde kendi ekiplerini oluşturmayı tercih edebiliyor. Ancak bu da ortaya çıkan işlerin profesyonelliğini azaltıyor.

Facebook, Disney ve Pixar gibi şirketlerin geliştirdiği yapay zeka destekli çözümler ise, kurum içindeki ekibin iş yükünü azaltırken, ortaya daha kaliteli işler çıkarılmasını sağlıyor.

Framework nasıl geliştirildi?

Ekip bu framwork'ü geliştirmek için bir yazılım simülatörü kullandı. Simülatör için çok çeşitli çekim türlerini içeren bir video klip veritabanı oluşturuldı. Framework'ün ardından etiketler ile belirli anlamsal tanımlayıcılar arasındaki ilişkiyi öğrenmesi için ise kitle kaynak kullanımı ve yapay zekadan yararlanıldı.

Bu yeni Framework'ün ortak yazarları, çeşitli çekim parametreleri için “algısal olarak geçerli minimum adım boyutlarını” yani bir dronun yapması gereken minimum çekim sayısını belirlemek için bir dizi deney yaptı.

Ardından ekip, bu adımları kullanarak 200 videodan oluşan bir veri kümesi oluşturarak Amazon Mechanical Turk üzerinden işe aldıkları kişilere, anlamsal tanımlayıcılara puan atama görevi verdiler. Verilen puanlar ise drone'u, çekimler esnasında yönlendirebilecek parametrelere eşleyen bir makine öğrenme modelini bilgilendirdi.

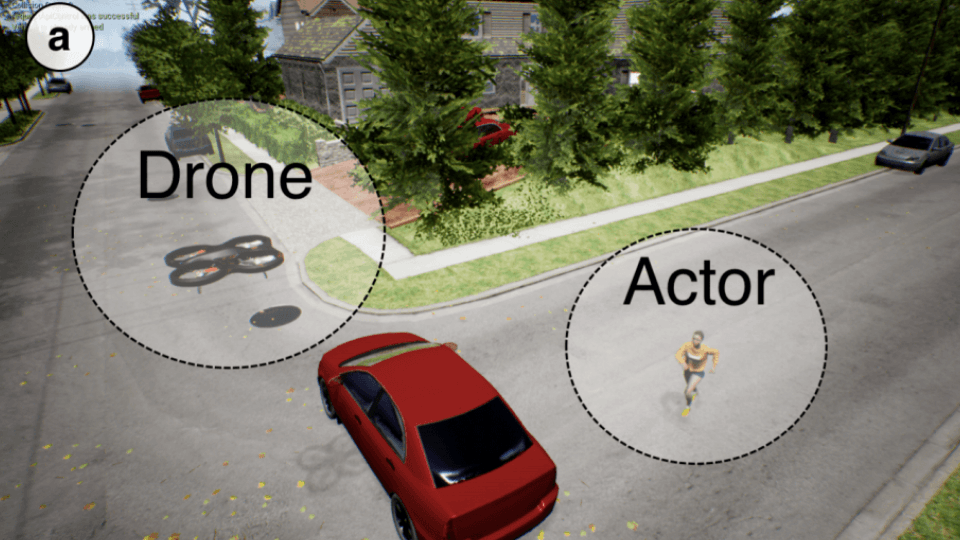

Son olarak ekip, framework'ü Parrot Bepop 2 insansız hava aracına yerleştirdi. Ekibin iddiasına göre, Parrot Bepop 2'ye yüklenen framework, farklı aktörlere, aktivitelere ve ortamlara iyi bir şekilde genellemeyi başardı.

İlerleyen süreçte, araştırma ekibinin daha geniş paratmetre setleri üzerinde çalışacağını belirtelim.Amaç, lensin yaptığı zoomları ve arka plan müzikleri dahil olmak üzere her bir karenin çekimini kontrol etmek. Önümüzdeki dönemde framework'e eklencek özellikler arasında manzara ve arazi çekimleri de yer alacak.

İlk Yorumu yazmak ister misiniz?

Yorum Yazmak için Giriş Yap